还是在这个熟悉的露天舞台,还是那个熟悉的面孔,还是我们熟知的 Google。

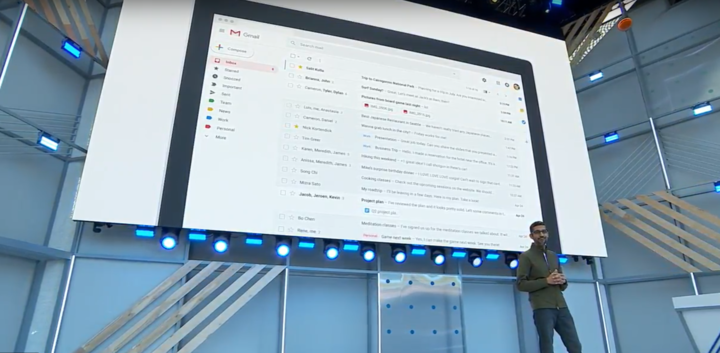

随着 Google CEO 桑达拉·皮蔡(Sundar Pichai)上台的一句「Good Morning」,今年的 Google I/O 大会正式开幕。

贯穿全场的 AI,依然还是今年的主角

大会一开始,皮蔡直入正题和大家回顾去年 Google I/O 大会后至今的改变,像「汉堡的奶酪位置变了」、「啤酒气泡从杯子里溢出」等等。

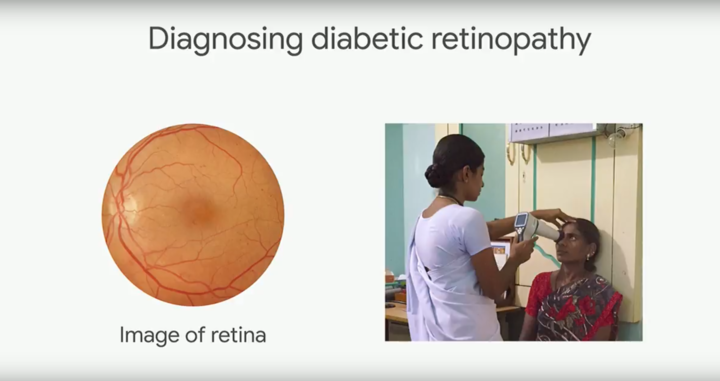

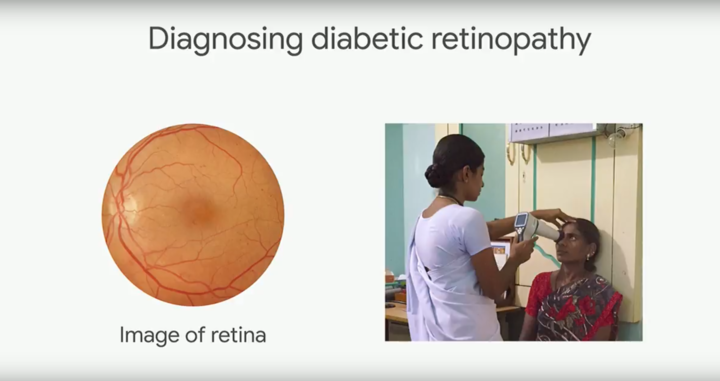

而经过一年的技术实践,Google 的 AI 技术也在各个领域中得到了长足发展。比方说在去年,Google 在医疗领域上通过 AI 技术对眼科病患者的视网膜进行诊断,并且在印度实验室中为科研人员取得了不俗的成果。

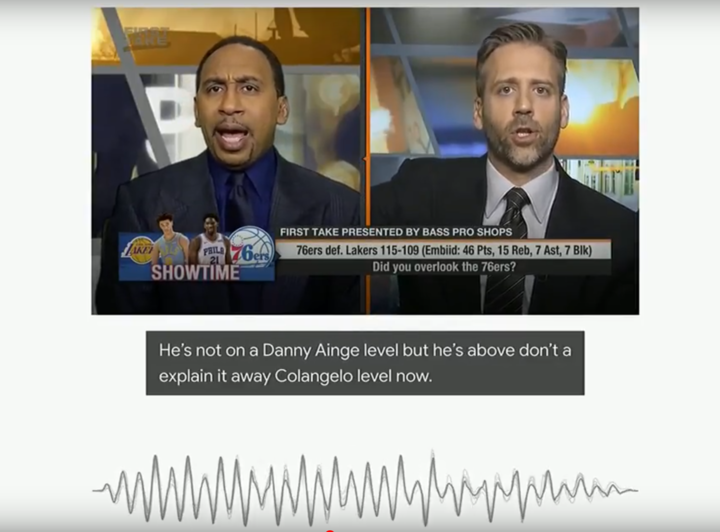

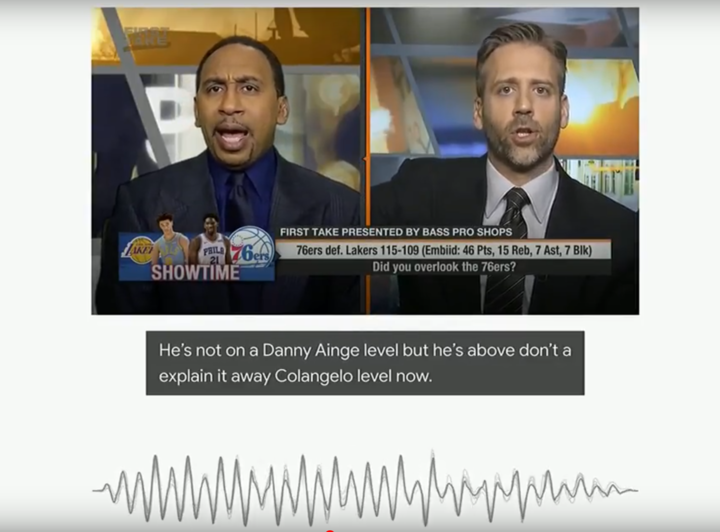

许多时候我们会在视频网站上看到外语类的视频,如果是找到有中文字幕的外语视频还算幸运,但若是遇到没有任何字幕的外语、口音模糊的视频就很尴尬了。

基于 AI 技术,YouTube 现在可以根据视频的图像和声音,对视频内容进行字幕翻译。即便是口音模糊的内容,AI 技术也能根据视频内容进行智能翻译,并通过底部字幕的方式进行呈现。

说白了,它的功能就是让你在看视频的时候更方便。

不过 AI 的作用可不止「翻译」这么简单。

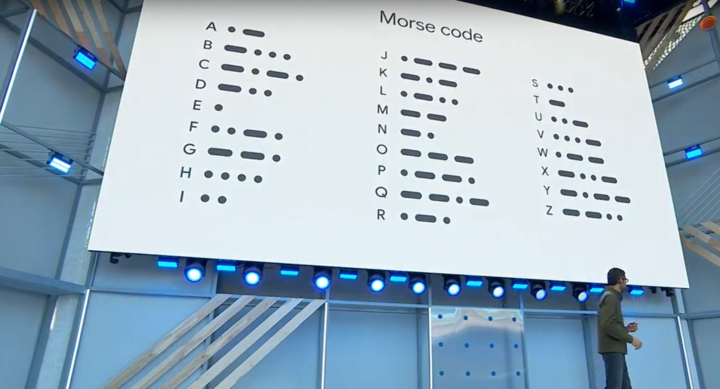

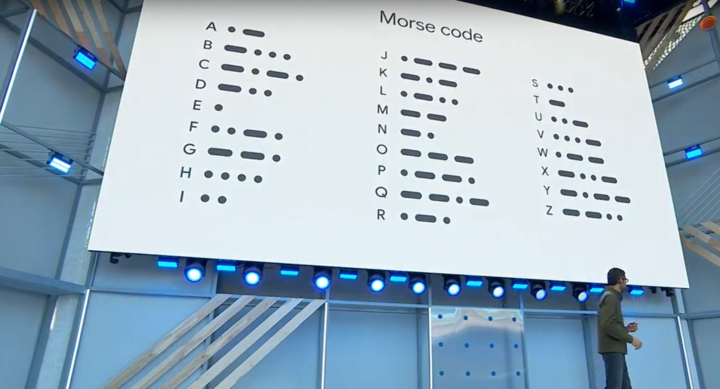

通过 Gboard 新加入的「摩斯密码」输入法、特定的输入装置以及结合 AI 识别,即便是行动不便的残障人士,也能通过该输入法与朋友进行沟通。

在现场的 DEMO 视频中,残障人士 Tania 通过使用头部在两侧的输入板中敲出「摩斯密码」,从而实现通过智能手机进行文字输入和语音输出,并与伴侣进行沟通。

在未来,更多需要帮助的残障人士也能通过新输入法和 AI 技术与外界进行交流。

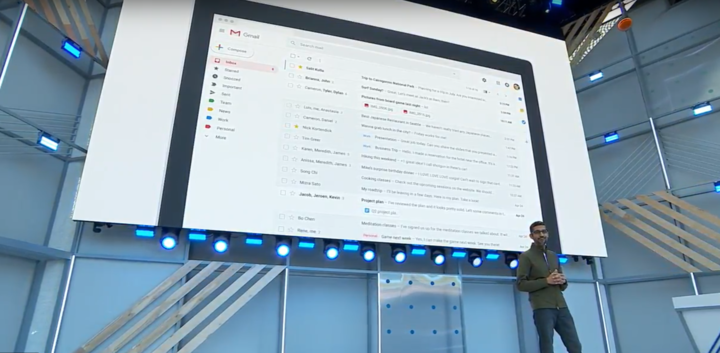

Gmail 邮箱除了在 UI 设计上有着新版改变外,同样也加入了 AI 技术,用户在编写邮件时 AI 会对即将输入的内容进行预判。

举个例子,当我在邮件编辑框中编写「我准备去」的时候,AI 会对我喜爱或常去的地方进行预测,并进行自动填充,以增加内容撰写的效率。

留给 Android 的戏份实在不多

早在两年前的 Google I/O 上,Google 就宣布今后的发展重点将会从「mobile first」到「AI first」。从那之后,过去一直是这场开发者盛会的绝对好戏 Android,慢慢变成了 AI 的陪衬,或者说是 AI 其中一个载体。

Andorid 研发副总裁 Dave Burke 一上台,回顾了 10 年来 Android 的历史,还提及了那台搭载过初代 Android 的 T-Mobile G1。

一晃十年…

一直担心以字母为系统代号的 Android 总有把 26 个英文字母用光的一天,而来到新一代的 Android 操作系统,也只剩下 10 个可用的字母了。

在开始下一个 10 年之前,Android P 到来了。

你可以说这是自 Android 5.0 之后,这个系统最大的一次升级,也可以说,它已经很难再有什么改变了。

说它是最大的一次升级,是因为从这一代 Android 开始,这套系统将会迎来新的手势交互方式,界面底部那三个早已遭人厌烦的虚拟键将成为过去。

关于 Android P 的体验,爱范儿会用一篇更加详细的文章来解读。

除了交互方式以及每年在 UI 上例行的小改动,Android 早已和 AI 密不可分。

扫描下方二维码,关注微信公众号爱范儿,回复关键词「P」获取固件包,尝鲜十年最大革新版本 Android P。

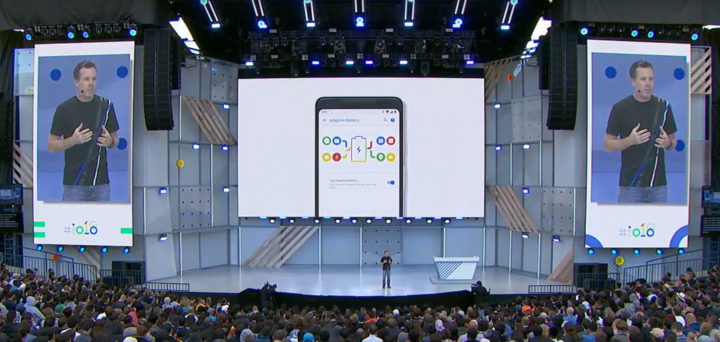

如果说 Google Assistant 进入 Android 是让人们用上酷炫的功能,那么靠 AI 来优化系统则是真正的用户福利。

比如在这个新系统中,Google 利用 AI 来帮助用户省电,AI 会监控手机的电池消耗,并关闭那些用户已有一段时间不用、但还在后台运行的应用。AI 还会根据用户的使用习惯调整手机的亮度,而不单单是靠光线传感器来解决。

当然,AI 的使用运行必然会涉及到大量的用户数据。不过 Burke 表示,这些数据只存在于用户的手机上,不会上传到云端,它们也只能在用户的设备上运行。

今天的 Keynote 上,留给 Android 的时间还没有去年多,或许,这也证明,Android 早已是一件成熟的作品。

让位于 AI,也不意味着它不再重要,毕竟还有 10 个字母没用完,我们期待着下一个 10 年。

越来越像一个人类的 Google Assistant

在前不久国外一家测试机构对当下主流的几个人工智能主力的测试中,Google Assistant 的「智商」完胜了亚马逊的 Alexa 以及苹果的 Siri。

而今天,Google Assistant 获得的新能力,可能会让所有人都感到不可思议。

首先,Google 为 Google Assistant 填了 6 中新声音,目前 Google Assistant 只有男声和女生两种声音,而它们听起来依然像机器,不太自然。

而这 6 个新声音,是更加接近于人类的声音。

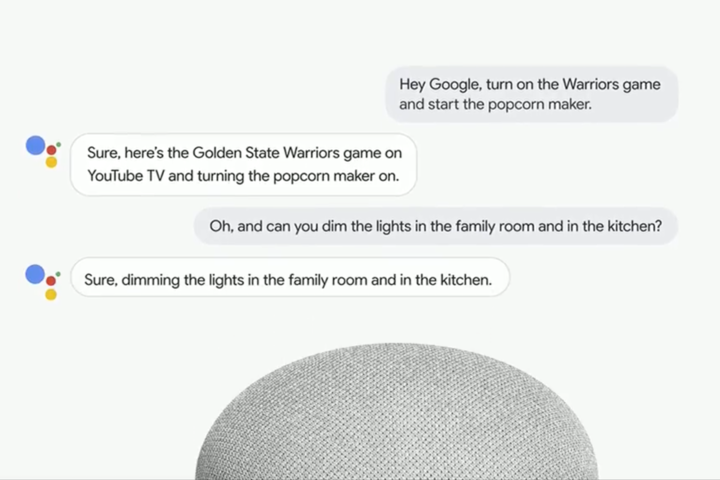

此外,Google Assistant 在语义理解和多轮对话能力上也有了进一步的提升。

在此之前,当用「Hey, Google」唤醒 Google Assistant 后,需要等待它响应个半秒钟才能进行下正式的对话。而现在,当用户说出「Hey, Google」后,可以立即直接说出接下来的指令,而 Google Assistant 的响应也比之前更快。

这也让用户可以获得更加接近人类对话的体验。

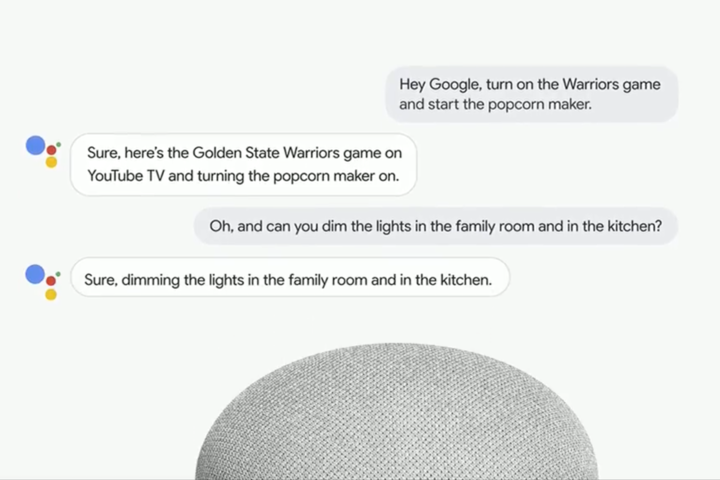

Google Assistant 还将能识别一句话中的多个指令,并对此做出一条完整的回答,这对人工智能助理在数据的处理和语义的理解上也有着很高的要求。

如果你觉得上面那些只是不疼不痒的小更新,那么接下来的这个,可能会让你觉得不可思议甚至会感到一丝可怕。

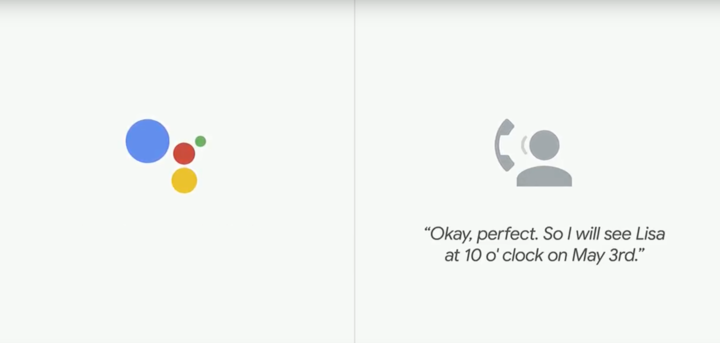

比方说——Google Assistant 可以自己打电话。

在现场的演示中,Google 展示了一项 Google Assistant 新功能的 Demo。

当你不方便接听电话,手机中的 Google Assistant 会变成你的「接线员」,或者更加确切地说,它会暂时「成为」你,来帮你接电话。

比如当你预定餐厅的时候,餐厅服务员会向你询问时间,姓名等信息来确认,但如果你正好有事不方便接电话,这时候 Google Assistant 则会与餐厅服务员对话,它能理解服务员所问得问题,并一一用语音进行回答。

更加不可思议的是,从现场 Demo 中传出的 Google Assistant 的声音,用于与人类无异的语气,而对面的服务员,完全不知道自己在和 AI 通电话。

Google CEO 皮蔡表示,Google Assistant 的对话都是经过机器学习积累完成的,目前它还在不断的完善中,也因此,我们在短时间内可能还不能使用上这个未来感十足的功能。

话说回来,或许未来某天当我们接到一个温柔的来电时,对方可能是个 AI 也说不定啊。

除了「说话」方面的升级,还有「视觉」方面的更新。

随着新功能而来的还有带屏幕的 Google Home,这类产品已经在今年的 CES 上亮相,并将在 7 月份上市销售,它的对手将会是亚马逊的 Echo Show。

此外,用户也终于可以在 Google Assistant 上通过语音进行购物及预定等操作。

当然,在这次 I/O 上,缺了智能穿戴平台 Wear OS,少了 AR 和 VR,我们不知道它们的命运如何,在 Google All in AI 后,它们显然渐渐退居次席。

不但能识别问题,还能解决问题的相机

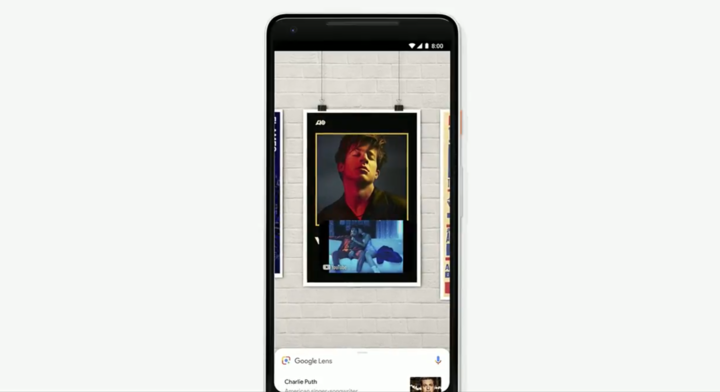

在去年的 Google I/O 大会上,Google Lens 以新功能的角色惊艳登场。

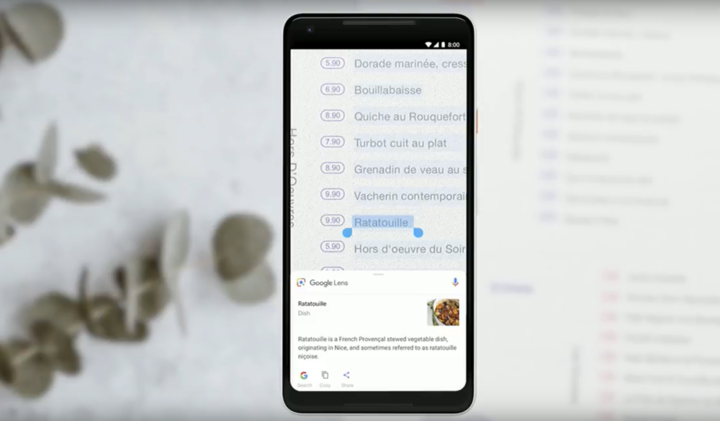

而在一年后的今天,Google Lens 不但能基于 AI 技术对文本、物体进行识别,而且也能够通过 AI 技术来解答用户「看见」的疑问。

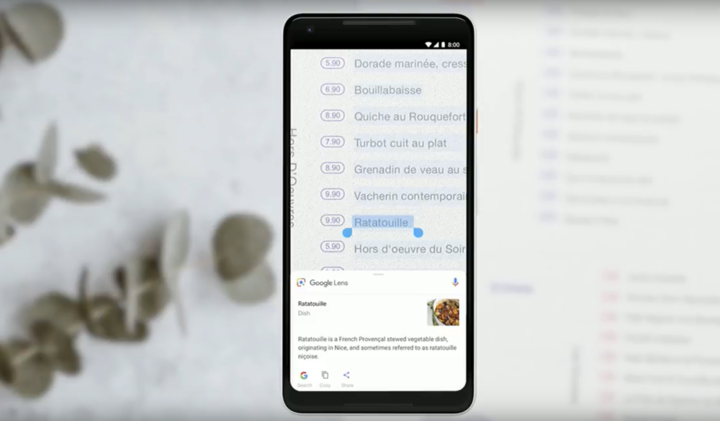

在识别文本后对内容进行复制、粘贴是 Google Lens 的基础功能。但在结合 AI 技术后,用户在扫面特定环境的单词后,可直接查看该物品的图像。

比方说我现在在餐馆,在点菜前我想看看这家餐馆的「凯撒沙拉」出品是怎样的。这时候我只需要使用 Google Lens 对菜单上的「凯撒沙拉」进行扫描,系统即可帮我反馈菜品的图片内容。

「文本识别」对于现在的智能手机来讲可能已经算是个「小儿科」了,再怎么说也只是一个文本识别系统而已。不过,今年 Google Lens 加入了对物体的风格匹配和场景实时匹配的支持,功能上比之前的 Google Lens 进步了不少。

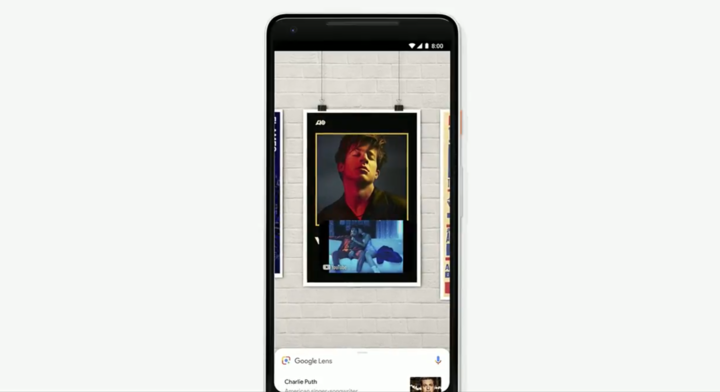

同样是基于 AI 技术,用户可以通过 Google Lens 对自己感兴趣的物体进行识别,并获得风格相似的产品;同时,Google Lens 也能通过实时的云 TPU 数据为用户提供所摄物体的实时检视,并提供检视的相关内容。

再举个例子,当 Google Lens 识别到某个歌手的画像时,系统会通过画中画形式将歌手的 MV 播放出来。

理论看上去比较枯燥,其实可以浓缩成一句话——

经过一年的技术沉淀,Google Lens 从帮用户「看问题」升级成了主动帮助用户「解答问题」了。

值得一提的是,本次更新 Google Lens 增加了对四家中国智能设备厂商的支持,其中包括有小米、华硕、一加和 TCL。

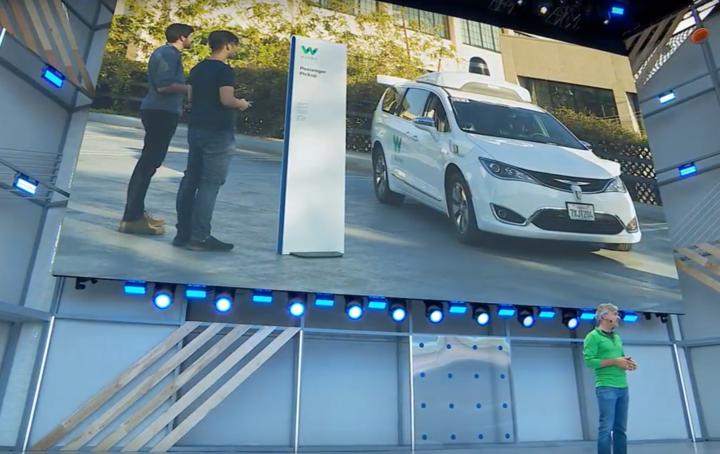

AI 不单只在手机上,甚至连车都能开了

无人驾驶是近年互联网热议的话题之一,在今年大会结束前,Google 向大家报告了与 Waymo 合作的无人驾驶技术现况。在经过累计 600 万英里的公路测试后,凤凰城会在不久后的将来成为 Google / Waymo 无人驾驶汽车的第一座试点城市。

AI 很强,但我们却仍有一丝遗憾

看完了这场将近两个小时的开发者盛会,我和熬夜的同事只觉时间过地太快。而我们没猜中开头,没猜中中间,也没猜到结尾。

没猜到这是 Google 最特别的一次开场。当 Google CEO 桑达拉·皮蔡说出「AI」这个词后,人们期待着 Google 将拿出震惊全场的新作品时,从皮查伊口中说出的却是「Responsibility」。

这个在很多人印象中理工男气质浓厚的科技公司,在那一刻要讲得却不是什么黑科技、不是什么新设备。而是作为一家科技公司的责任,一个面向社会的责任——「Deep responsibility to get this right」。

我们没有猜到 Google Assistant 能够像人类一样和人类通电话,昨天我还在和朋友开玩笑说 AI 界也就靠估值刷刷存在感了,今天就被 AI 打了脸。即便这个人工智能还有很长一段路要走,但 Google 又一次让我们知道了 AI 并不完全是个泡沫。

我们没猜到结尾,是因为有些草草收尾而意犹未尽,我们还没来得及吸收如此多的信息,就只能期待着下一年的 I/O。

这一次,面对依然能够令人兴奋的 Google I/O 大会,希望我们不用再有临渊羡鱼之感,见证了就好。

题图来源:9to5google丨本文由文俊与刘罕共同编辑