Google 人工智能,掀开盖子里居然有个活人

怎么样开一家人工智能公司?

答案可能比「如何把大象塞进冰箱」还简单。

文档软件开发商 Readme 的创始人 Gregory Koberger 曾经在社交网站上回答过这个问题:

1、请一群领最低工资的人来假装人工智能

2、等真正的人工智能创造出来

Gregory Koberger 当时之所以这样说,其实是为了讽刺早前人工智能创业公司 Edison Software 被曝出聘请员工假装 AI 为客户提供所谓的「智能邮件回复」服务。

事情过去也快一年了,没想到这个梗再一次被挖了出来,更没想到的是,这次讽刺的对象居然还是鼎鼎大名,被给予厚望改变世界的 Google。

Google 也骗人了?

准确来说是 Goolge Duplex 骗人了。

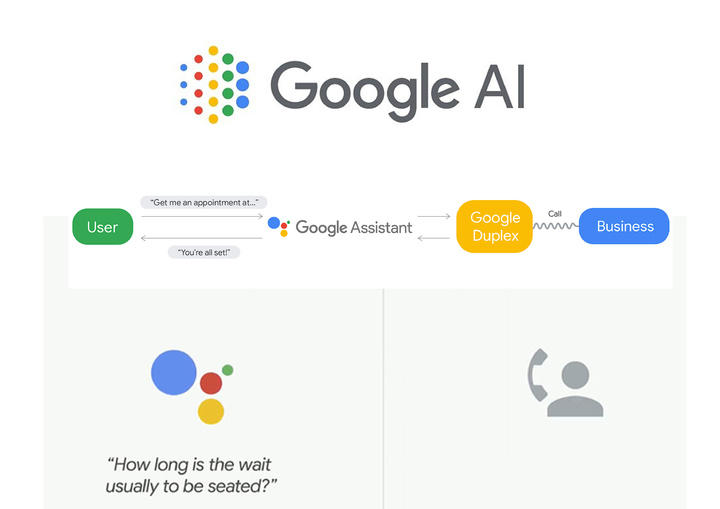

在 2018 年,Google 在 I/O 大会推出了一项人工智能新服务:Google Duplex。这项人工智能服务的用处,简单来说就可以替你打电话到餐馆订位。

Jimmy Tran 是一家位于加州的泰国餐馆的服务员,前些天,他接到了来自 Google Duplex 的订位电话。

但在交谈的过程中,对方浓重的爱尔兰口音(拜托,能不能走心一点)引起了餐馆小哥的怀疑。

餐馆小哥也毫不含糊,直接问对方究竟是 AI 还是人,没想到对方更直接,丝毫不掩饰,直接承认了自己其实是人。

估计餐馆小哥内心觉得憋屈:等了这么久,终于等来了 Duplex 的电话,结果你跟我说其实你是个人?于是他找《纽约时报》告状去了。

《纽约时报》也发现事情并不简单。于是他们也进行了十次实验,结果发现,十次当中有四次是成功订位的,而这四次当中仅有一次是真的通过 AI 来进行订位的,其余三次其实都是「演员们」的表演。

随后,Google 也向《纽约时报》承认了此事,并表示 Duplex 所拨出的电话中,有 25% 其实是人类,而在剩下的电话中,也有 15% 进行了部分的人为干预。

显然,百分比其实并不重要,重要的是有和无。

那么即便神奇如 Google Duplex,也摆脱不了人工干预?

Duplex 神奇的地方,其实用处并不大

其实用「人工」装「智能」的事也不是第一次出现了。除了文章开头提到的「伪装智能回复邮件」事件外,你还记得那个甚至还被授予了沙特国籍的神棍机器人 Sophia 么?

至于这次 Google Duplex 的事情之所以还能引起大家这么大的关注,其实还是因为大家对 Google Duplex 的期望太高了。

一年前,Google Duplex 一出,「Awsome」声四起。

下面的视频给没有看过或者是已经忘了 Google Duplex 是如何订位的同学了解/复习一下。

惊艳的感觉从何而来?你一定会回答:太像人了。

对,太像人了。Google Duplex 甚至还通过了部分的图灵测试——一个说到 AI 就会想到的测试,就像是 AI 的认证考试一样。

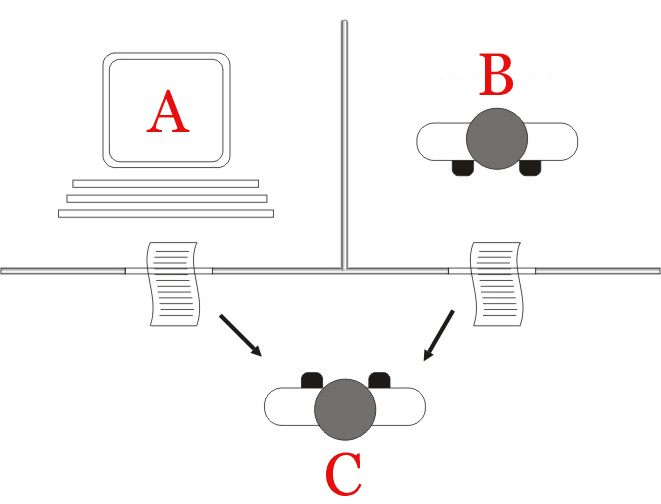

图灵测试简单来说,就是把真人和 AI 都关到「小黑屋」里面,然后在屋外安排另外一个真人轮流与他们对话。如果屋外的人无法辨别出「小黑屋」里到底哪个是真人哪个 AI,那么则会认为这个 AI 通过了图灵测试。

但是,通过了图灵测试,就能说明这个 AI 能正常地与人交流了吗?并不,因为图灵测试的本质是模仿、是欺骗,这样就使得 AI 在进行图灵测试时,遇到理解不了的问题,只要它表现得足够像人类,就可以通过假装无知,对问题避而不谈来通过测试。

▲图片来自:Wikipedia

无可否认,在模仿人类这方面,Google Duplex 做得实在太好了,无论是语音语调、各种停顿、语气词等的小动作都做得与人几乎没什么区别。这也是它通过图灵测试的资本所在。

但是,即便 Google Duplex 在语音合成上做得再极致,也没有用,因为人工智能对话系统,关键不是在于话说有多像,而是能听懂话,说对话。就好比唱歌找不着调的人,嗓音再好听,也于事无补。

能听懂人话其实才是关键

为什么让 AI 听懂人话这么难?这得从 AI 到底是怎么理解所听到的话(NLU 自然语言理解)说起。

包括 Google Duplex 在内的人工智能对话系统,对听到的每一句话,都会进行拆解,将其分成「意图」、「实体」以及「废话」。

例如你说一句:今天天气真好,我想去广州塔逛逛,帮我叫个车吧。

在这句话当中「叫车」就是「意图」、「广州塔」就是目的地实体,其余就都是废话了。

▲图片来自:Boost.ai

那么在这里,第一个问题就出现了。

例如:帮我推荐一家餐厅,不要四川菜。

在这句话当中,意图很明显,是「推荐餐厅」但是「四川菜」依旧会被当成实体,「不要」这个重要的关键逻辑,则会被当成废话。

人之所以可以理解这句话,是因为人除了可以提取关键词之外,还可以进行逻辑的识别,而 AI 所缺少后面的这一步,就让它在进行理解时,脑筋经常转不过来。

另外,还有一个问题,让现在的 AI 对话系统,和人类的对话系统有着巨大的差距。

无论你说的是哪种语言,你总有办法把信息揉进语言里面。

但是作为人类最重要的传达信息的工具,语言系统却并没有我们想象中的那么高效。我们举个例子。

假设周日晚上你在酒吧认识了个姑娘,她迷人的脸庞加上有趣的灵魂让你神魂颠倒。即便到了周一早上,你依旧像个花痴一样,一想起她就傻笑。

于是同事就来问你了:吃错药了?

你回答:我昨晚遇到了一个很棒的姑娘。

那么这个姑娘究竟有多棒?你同事并不会知道。

因为即便你在接下来的一个小时里,用尽各种语言去描述那个姑娘长得怎么样、不停地复述你们昨天聊的话题究竟多有趣,在你同事的脑海里,依旧无法一比一地把那个女生复刻出来。

比起我们的思维,语言确实很贫瘠,以至于实际上通过语言所传达的信息,其实或多或少是失真的。

那么为什么人类还可以通过这样的一个系统,正常传达信息,并以此建立起延续了七千多年的文明?

这是因为我们解读能力强。

这就好比我们的主编每天早上见到我说了一句早安后,第二句我都还没等他开口,就已经知道他想问我稿子写完没。

也好比你的同事即便无法在脑海里一比一地把那个姑娘复刻出来,只要他不是从出生开始便一直单身,他都能理解你这种如沐春风的感觉。

这种基于常识、经验、场景、直觉来解读语言、获取信息的能力,正正是目前仅能通过上下文进行意图及实体提取的 AI 来说,最为缺乏的。

而想要做到十分自然的交流,这种能力必不可缺。

实际上,图灵测试还有一个升级版:威诺格拉德模式挑战。这个测试,就是用来检验 AI 能否根据常识来解读语言的。

但可惜的是,目前的人工智能对话系统,在该测试上,都表现得并不乐观。

其实对于单靠深度学习,能否造出真正的人工智能对话系统,是有学者持怀疑态度的。

深度学习并不像大家想象的那样,你把这个 AI 造出来,然后他就会自己开始学习。目前的深度学习还停留在监督学习,以及半监督学习状态。这也就是说必须靠人去「喂」大量的标注数据,让 AI 的「实体」库和「意图」库丰满起来,做到无论你是说「我饿了」还是说「我想出去吃饭」AI 都知道需要为你推荐餐厅。

但事实上,即便这个库再大,上面两个问题其实都很难解决。

心理学家认为人的大脑有两个系统,系统一负责处理靠直觉、习惯就能完成的事情。而系统二所负责的事情则需要通过思考来完成。

专注于人工神经网络以及深度学习的计算机学家约书亚·班吉欧认为,语言是靠系统二来处理的,但是基于深度学习的人工智能,实际上更像是系统一。

当然,这里并不是在传达什么「深度学习无用论」,因为也有另外一种观点认为,人本身就是一种数据库,所有经验、常识甚至是直觉其实都可以被量化。只要解决这个统计上的问题,真正的人工智能对话系统依旧有望可以通过深度学习去达成。更何况,即便是需要重新找另外一条路,深度学习依旧会有它的一席之位,毕竟任何一种发明的诞生,其实都是多种技术的结合。

但无论是推倒重来,还是继续往深度学习的方向发展,想见到能够真正能够自然交流,而且不是朝九晚五的人工智能对话系统,可能还需要走很长的一段路才行。