如何辨别 AI 写的假文章?最好的办法还是用回 AI

解铃还须系铃人。

这句话的意思是谁引起了麻烦,那么就由谁去解决。而如今,这句话用在麻省理工学院的 AI 查文工具 GLTR(巨型语言模拟器)上似乎也同样合适。

GLTR 是一款由麻省理工学院和哈佛大学 IBM 沃森人工智能实验室的人工智能文本识别工具。这款工具的工作原理,是通过检测文本撰写逻辑、文本用词来对文章进行判断,即通过文章语句的组成方式、对单词运用的手法进行人工撰写和 AI 撰写的识别。

比如,当 AI 炮制出一篇新闻,那么它只是会以复述的形式机械地向读者陈述事件,并没有主观情绪和意识,也没有写作手法特点,那么 GLTR 就会判断出该文章为 AI 撰写文本。

同理,当评论语句是由简单的单词组成,那么 GLTR 也能识别出由 AI 灌水的评论。

GLTR 的「对手」,其实是近年由马斯克倡导成立的 OpenAI,不过说来也是有趣,OpenAI 同时也充当着 GLTR「孵化器」的角色。

今年初,OpenAI 公布了一款文本生成工具(GPT-2),这款工具能根据用户给出的多个信息点去整理并生成出一篇假新闻。

尽管 OpenAI 在展出这款软件后一再强调它的作用只是用于未来的 AI 语言建模,即通过 AI 对人类的使用习惯进行学习,继而在未来以接近用户的编写方式去自动补充文本内容,演示的新闻编写只是工具能力的展示方式。

但由于该工具已经具备基础的内容编写能力,所以也不排除这款工具在未来会参与到假新闻、假评论创作当中。因此,IBM 沃森人工智能实验室以 OpenAI 的公开代码为蓝本,在编译功能的基础上加以改良,最后推出了这款具备逆向检测功能的 GLTR。

正如大家经常开的一个玩笑:AI 当中出现了「叛徒」。

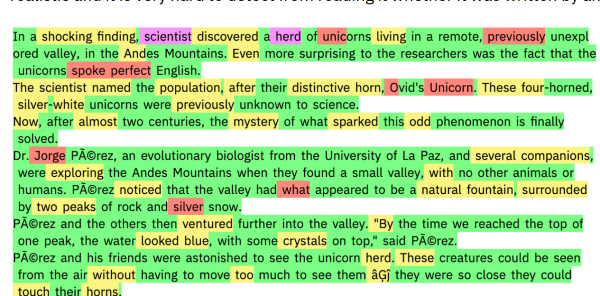

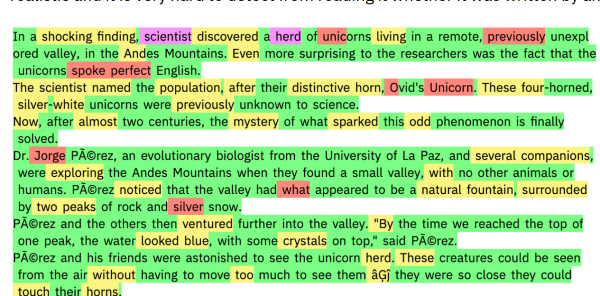

GLTR 的预测结果分为容易(绿)、较难(红/黄)、很难(紫)几种。其中「很难」为最接近人类用词撰写的词语或句子;「容易」则最有可能是由 AI 编写的语言,因为 AI 所获得的信息量有限,而且句式搭配单一和机械,所以 AI 就能根据单词和词组对内容进行筛选,最后得出是否由 AI 撰写内容的结果。

怎样的句式才属于人类创作?哪些措辞是 AI 常用的?

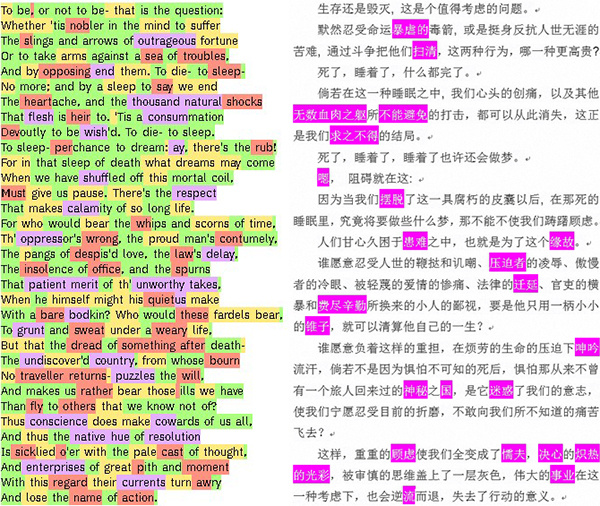

澎湃新闻的记者用工具对《哈姆雷特》的其中一小段进行检测,最后发现单单一页纸的内容,就已经能找到多达 20 个标紫的结果。

比如在文章中,莎士比亚就用了「暴虐」、「炽热的光彩」来修饰命运和光彩,这些都是常人不常用的写作手法,对于 AI 来说,这些可以说是从入门到精通的超能级别了。

▲ 图片来自:澎湃新闻

相比于人类对 AI 内容的辨别,GLTR 在实验中已颇显成效。根据 GLTR 研究团队的测试结果,在同一篇由 AI 杜撰的文章中,参与测试的哈佛学生辨别出了近 50% 的虚假文本,而在使用 GLTR 工具后,辨别能力提升到了 75%。

虽然在复杂的现实场景中,GLTR 尚未做到 100% 的准确率,也尚未能真正投入使用,但在测试中能为人类提升 25% 的效率,也已经是个相当喜人的表现了。

果然知己知彼非常重要。

有学者认为,随着社交平台、内容媒体在近年井喷发展,假新闻、假消息、假评论也随之在网络泛滥。而 GLTR 在未来有望能成为人类辨别 AI 假内容的辅助工具,它能帮助用户及时避免假新闻、假评论所可能会带来的损害。

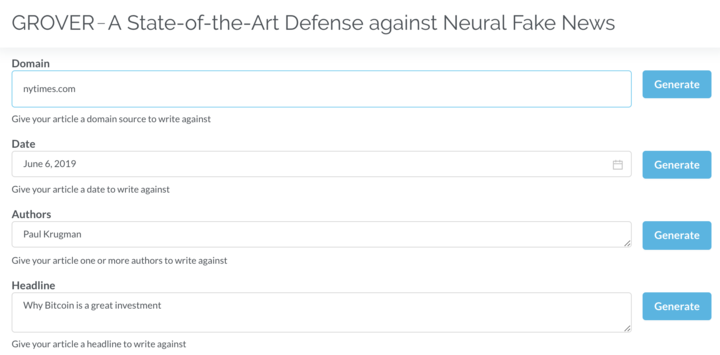

实际上除了哈佛和麻省理工的 GLTR 以外,华盛顿大学和艾伦人工智能研究所也在早些时候推出了一个同样是基于 OpenAI 代码设计的文本检测工具,名为 GROVER。

比 GLTR 更有意思的是,GROVER 除了具备文本预测能力外,还能对一些知名刊物的写作风格进行模仿,包括《纽约时报》、《连线杂志》等等。

比如我在 GROVER 的官网选择《自闭症与疫苗的关系》这么一个标题,系统就能模仿 CNN 的写作风格帮我生成了一篇假新闻。而且我还能在编辑框中调整文章的撰写日期、作者和标题,甚至还能对正文进行微调,以达到以假乱真,真上加真的目的。

通过 AI 生成一篇有理有据的评论文要多久?GROVER 的官网说要 30 秒,但实际上在网络畅通的时候,只需 10 秒就能得到一篇由 AI 炮制的假新闻了。

而与 GLTR 一样,GROVER 同样也提供了文本预测功能,这让我不禁想起《猫鼠游戏》中的弗兰克——他是一个造假支票的专家,同时也是验假支票的专家。

随着 AI 的算法不断学习和升级,AI 撰文在今天可以说已经达到了能以假乱真的地步,这也间接催生出了如 GLTR、GROVER 这些识别软件的问世。

当然,人类想要辨别出假文章也不一定全靠 AI 辅助,比如按照 GLTR 的逻辑,本文的第一句话就能证明这是一篇由人类撰写的真文章,而且本文我总共花了 30 分钟撰写,比 AI 足足慢了 60 倍呢。