麻省理工学院做了一件 T 恤,穿上就能在 AI 摄像头前「消失」

前几天中国迎来了「人脸识别第一案」,浙江理工大学一位教授因不满杭州野生动物世界强制要求年卡用户注册人脸识别,因此将动物园告上法庭。

随着人脸识别技术的普及,事实上在生活中,我们很多时候都不知道自己的脸什么时候正在被识别。尽管美国旧金山等城市已经出台了人脸识别的禁令,但在更多国家和城市,相关的法律政策还没跟上。

▲ 图片来自:South China Morning Post

对于可能无处不在的人脸检测系统,我们除了呼吁完善监管还能做些什么?最近西北大学和麻省理工学院的沃森人工智能实验室(MIT-IBM Watson AI Lab)开发出一种印有特殊图案的 T 恤,只要穿上就能躲过 AI 系统的监控,让一个大活人在监控镜头前「消失」。

这是什么做到的?其实原理并不复杂,研究人员了使用一种称为对抗性机器学习的方法来欺骗 AI,因为计算机视觉识别系统一般依赖大量数据训练在提高识别的准确率,通过同样的方法也能找出能够欺骗系统的图案。

▲ 图片来自:OpenAI

早在 2014 年,Google 和纽约大学的一项研究就已经证明,物体和人脸识别的算法容易受到以对抗性学习为基础的攻击。今年 4 月份比利时鲁汶大学 (KU Leuven) 的研究人员就通过这个原理,用一张贴纸成功欺骗了 AI 系统。

但这种欺骗 AI 系统的方式有一个缺陷,只要图案的角度和形状发生变化,就会轻易被识破。因为过去一般都是用硬纸板、停车牌或玻璃款等硬物来做载体。

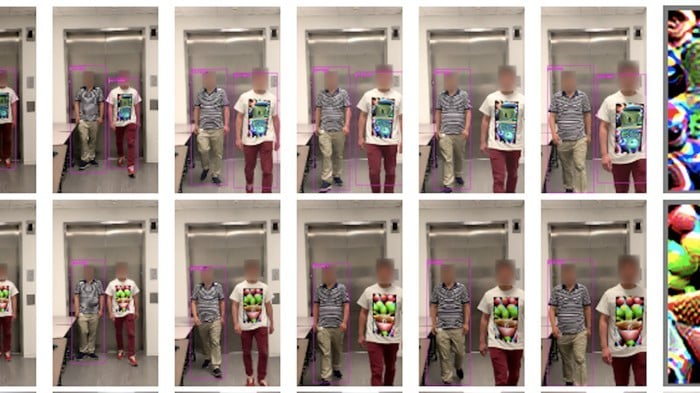

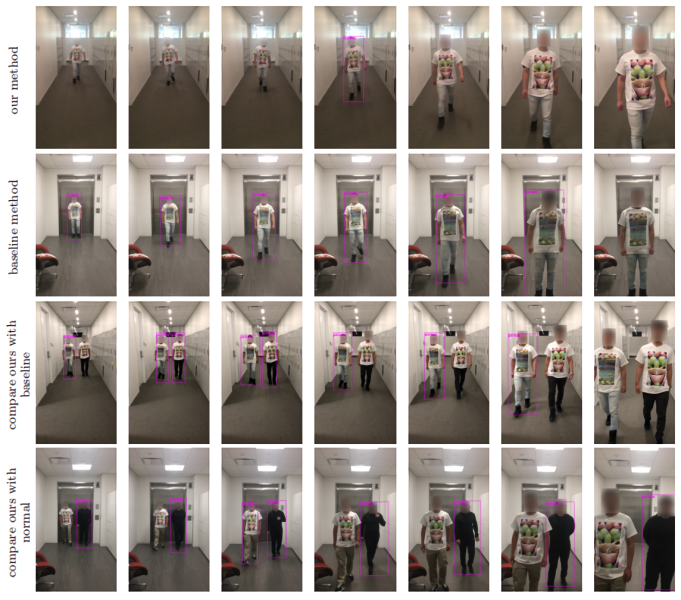

这次麻省理工研发的 T 恤的突破在于,即便衣服上的图案追随着人的姿势变化而变形,一样能欺骗 AI 系统。

研究人员指出,对抗性机器学习经常被用于欺骗计算机视觉系统,但还难以根据在随着运动而变形的衣服上建模,因此他们采用了一种叫做「薄板样条线(TPS)」的数据插值和平滑技术,该模型可对具有重复射(保留点、直线、平面)和非仿射分量的坐标进行转换并建模。

简单来说,这项技术让柔性物体也能模拟刚性物体的对抗性学习,从而欺骗 AI 。

从图片中可以看到,这种 T 恤 上印有黑白棋盘格子式样的图案,在系统识别时每个格子之间会出现红色的小点,这就是成薄板样条线(TPS)转换的控制点。

研究人员分别在现实和虚拟环境中测试这种 T 恤 ,准确率分别能达 63% 和79%。不过如果在同一画面上出现两个或者更多穿着这种 T 恤的人,成功率则会降低。

同时这种方式一样有局限性,只能骗过特定的识别算法,对于 Amazon Web Services,Google Cloud Platform 和 Microsoft Azure 等识别系统并不使用。但研究人员表示这只是「迈向对抗性可穿戴设备的第一步」,为针对 AI 的对抗性干扰提供一些启发。

当人脸识别等 AI 算法与人类的矛盾日渐凸显,未来这种欺骗 AI 的需求可能会越来越多,甚至成为一种新的职业。

题图来自:Inc