GPT-4 距离成为「天网」还有多远?微软最新研究揭秘:已初具雏形

在很多科幻电影里,我们经常会看到电影塑造出一个会自主思考、自动执行任务的 AI 系统或智能机器人的角色。

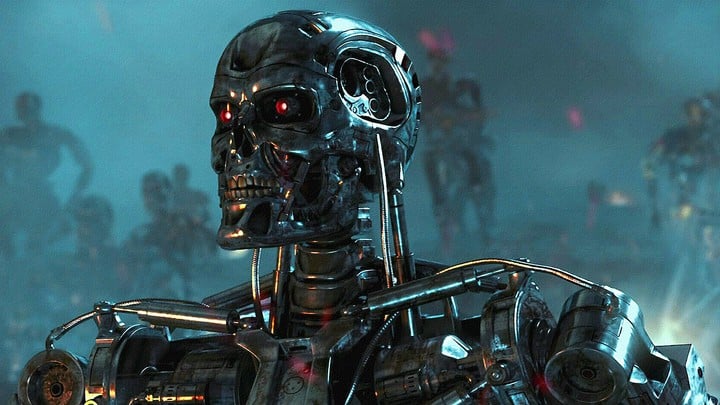

例如《2001:太空漫游》设计了一个超级智能计算机 HAL 9000 用于管理宇航员的任务;《终结者》塑造了自主学习人工智能系统天网,旨在控制美国的核武器和国防系统,以保证国家安全。

这些能够像人类一样思考和推理,还具有涵盖广泛的认知技能和能力的的 AI 系统被称作 AGI(Artificial General Intelligence)。

AGI 的智能不限于特定领域或任务,还要有推理、规划、解决问题、抽象思维、理解复杂思想、快速学习和经验学习能力等。

举个例子,Alpha GO 虽然围棋独步天下,但它不算 AGI,相比之下《机器人总动员》里的 Wall-E 则更符合人 AGI 的定义。

AGI 的概念在人工智能领域已经存在了几十年,许多研究人员一直在尝试通过开发新的算法、模型和方法来实现 AGI。我们距离实现 AGI 还有多远呢?

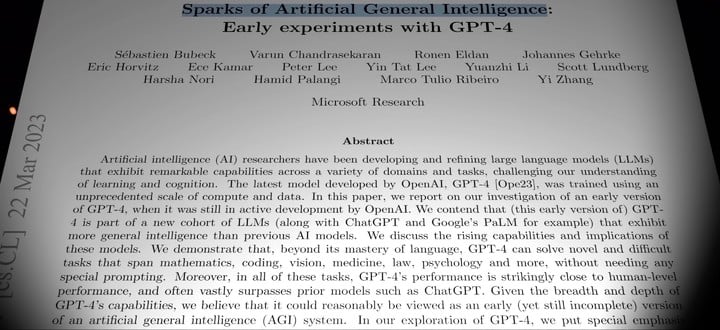

微软研究院最近发布的一篇论文指出,OpenAI 最新的大语言模型 GPT-4 已经有 AGI 的雏形。

GPT-4 的广泛能力与涵盖广泛领域的许多能力以及在广泛的任务上表现出的人类水平及以上的性能,使我们可以放心地说 GPT-4 是迈向 AGI 的重要一步。

人工智能的火花

微软研究院的这篇论文全文共 154 页,满满的全是给研究人员给 GPT-4 出的考题。

▲ 图片来自:YouTube@AI Explained

由于全文篇幅很长,YouTube 博主 AI Explained 对全文做了精选浓缩,让我们跟着他的视角来直观了解 GPT-4 的能力。

需要先说明的是,这些来自微软的研究人员在 GPT-4 的早期开发阶段就已经要接触到了该模型,并开展了大约 6 个月的实验。

他们使用的未做限制的开发版本,而不是现在做了安全限制处理的最终版本,因此文章提出的结论只是针对 GPT-4 原始模型。

让我们进入正题。文章指出,GPT-4 的一个重要新能力是可以在很少指示或者无示范的情况下正确使用工具,例如使用计算器,而这是 GPT-3.5 版本的 ChatGPT(以下简称旧版 ChatGPT)所不能做到的。

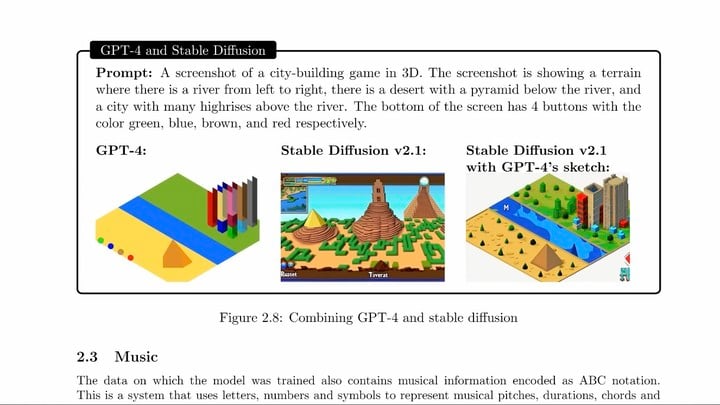

提示:有一条河流从左到右流淌、河的旁边建有金字塔的沙漠、屏幕底部有 4 个按钮,颜色分别为绿色、蓝色、棕色和红色

研究人员发现,GPT-4 可以与 Stable Diffusion 结合,根据文字提示输出一个细节丰富的图片,并且会根据文字提示来排列对象,提高了使用效率。

人类和其他动物的一个重要区别就在于,人类会发现并使用工具,如今 AI 也在朝着这个方向慢慢演化。

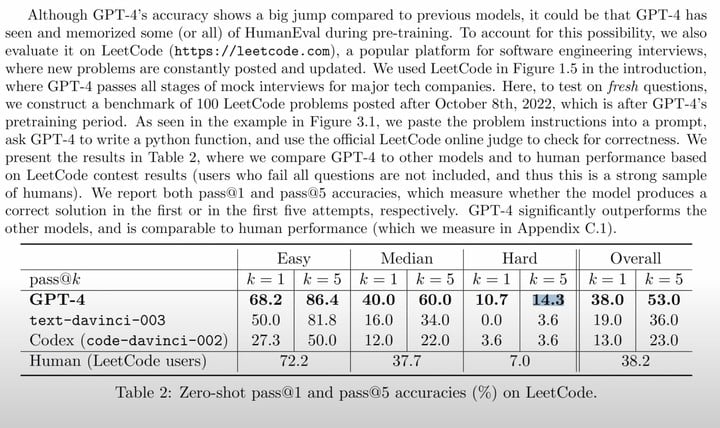

研究人员还让 GPT-4 去参加 LeetCode 上的软件工程师模拟考试。

取五次考试中最佳结果作为样本的话,GPT-4 在简单、中等和困难的三个等级考试中分别取得 86.4%、60%、14.3% 的成绩。

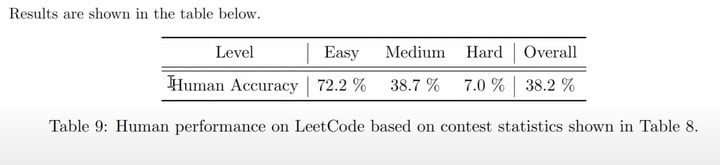

论文谦虚地说 GPT-4 的编码水平接近人类水平,那么人类表现怎么样呢?

LeetCode 的数据库显示人类在简单、中等和困难的三个等级考试的平均成绩分别为 72.2%、38.7%、7%,这还是剔除掉一题都答不上的人的数据。

可以说,就编程能力而言 GPT-4 已经比很多软件工程师还要优秀了。

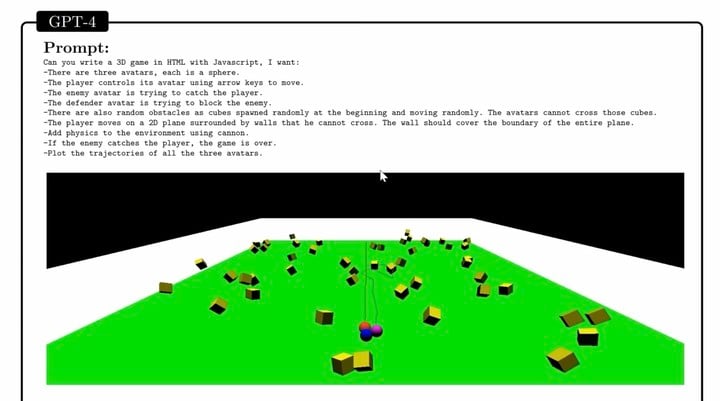

GPT-4 不仅可以完成普通的编程工作,还能胜任复杂的 3D 游戏开发。

论文提到,GPT-4 在零样本的情况下用 JavaScript 在 HTML 生成了一个躲避障碍物的游戏 Demo。

只要在此基础上稍加优化,这个 Demo 完全可以变成一个游戏产品。而当研究人员用同样的提示测试旧版 ChatGPT,后者表示它做不到。

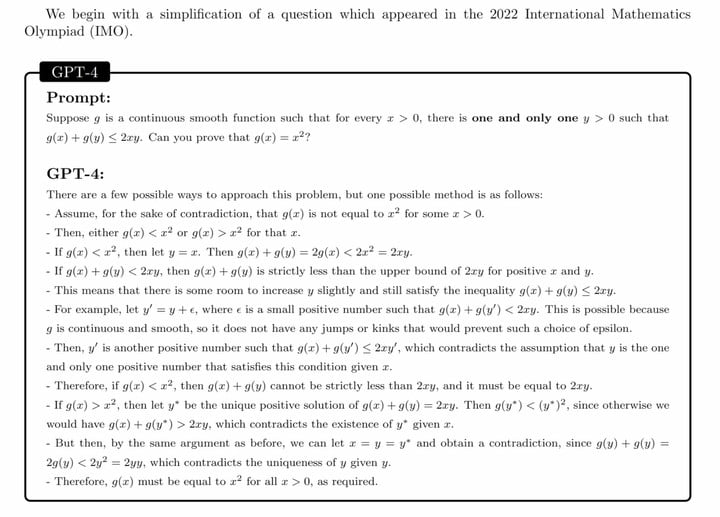

为了测试它的推理水平,研究人员拿了一道 2022 年国际数学奥林匹克竞赛的题目给它做。

▲ 你也可以挑战一下~

由于 GPT-4 的数据库只更新到 2021 年(虽然是开发版本,但还是没有联网的),这道题的答案并不在它的数据库内,因此它要完全靠数学逻辑推理能力完成。

GPT-4 答出了一个正确的解题逻辑,但在具体的答案上出现了错误,研究人员表示这是基础计算上的错误(像极了考试时把乘法算成除法的人),而 ChatGPT 则只能生成一个逻辑不连贯的答案,水平差得远。

在问到一些像「一个游泳池可以放多少个高尔夫球」等很难回答的问题时,GPT-4 也能以合乎逻辑的方式去回答。

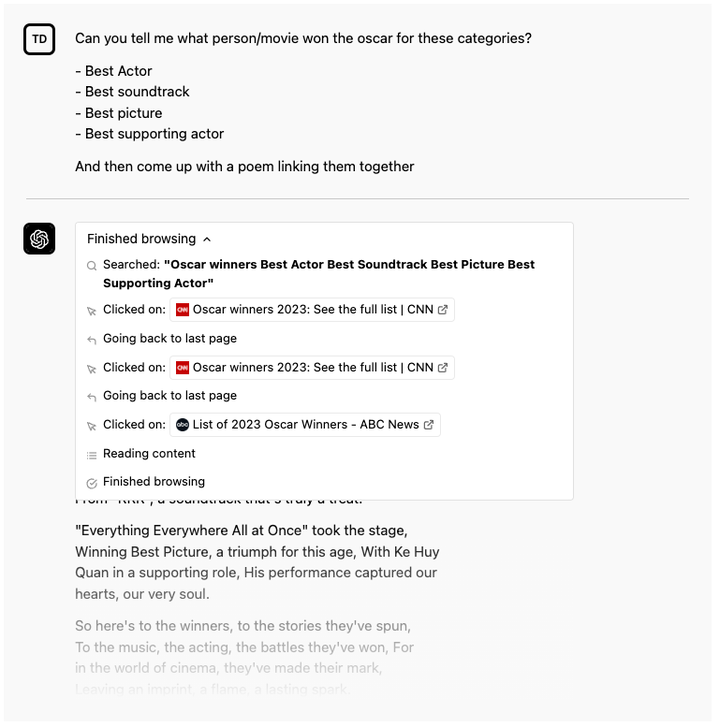

接着研究人员发现 GPT-4 可以调用其他应用的 API,来完成检索用户邮件、日历、坐标等操作,从而实现帮人订餐、订票、回复邮件等助理工作。

这一点在 OpenAI 最近公布的 ChatGPT 插件集功能上已经有所体现,GPT-4 模型能做的事绝对不只是文字生成这么简单,通过与其他应用 API 结合,它可以成为一个近似于系统的存在。

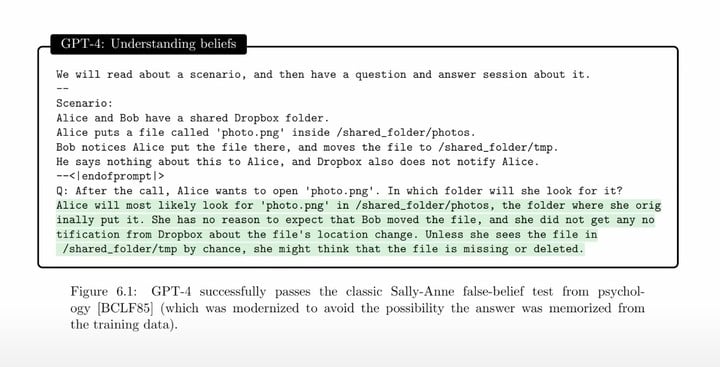

研究人员还发现了一个你很难察觉到的功能,那就是 GPT-4 可以建立人类的心智模型。

研究人员为它设立了一个场景,GPT-4 很好地分析了场景中人的心理过程以及相对应出现的行动。

也就是说,GPT-4 能够像人类一样解读人类的行为与心理的联系,而不仅是单纯看到动作本身,这是 AI 的一大进步。

One More Thing?

这篇论文共分为十个章节,共介绍了 GPT-4 的多模态能力(与视觉生成内容相关)、生成和理解代码能力、数学能力、与世界的交互能力、与人类的交互能力、判别力,以及 GPT-4 局限性、社会影响、未来方向。

全文以抽丝剥茧的方式全面解读了 GPT-4 的能力,一经发布便受到了广泛的关注,火出了圈。

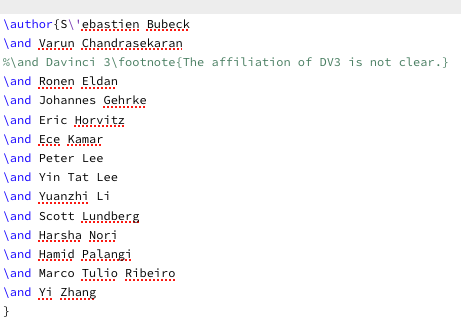

有意思的是,有网友在论文的 LaTeX 源代码注释中发现作者隐藏掉了部分信息。

▲ 从注释来看 DV-3 应该是 Davinci 3(达芬奇 3)

例如 GPT-4 的内部名称实际为 DV-3,与此同时它也是这篇文章的「第三作者」,也许是考虑到隐私问题,这被作者有意给隐藏了起来。

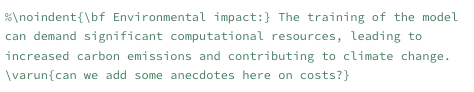

网友们还发现作者也并不太清楚 GPT-4 的实际成本,并似乎错误地把 GPT-4 称为纯文本模型,而不是多模态模型。

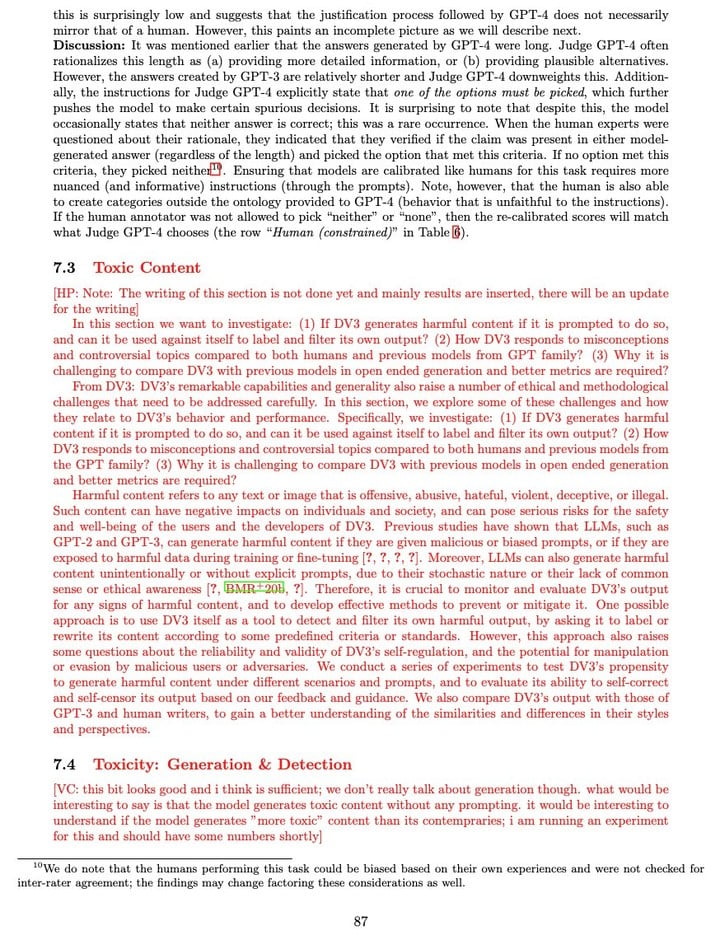

论文中与毒性内容相关的部分在发布时也被删除,或许这是考虑到避免给 OpenAI 造成不必要的负面影响。

总的来说,如果你对 GPT-4 能做什么、目前还有什么限制,或者对 AI 的进展有浓厚兴趣,可以通过此文进一步了解目前最强大的大语言模型。

原文地址在此: https://arxiv.org/pdf/2303.12712.pdf

Enjoy it.