申请 ChatGPT 和新 Bing 们的账号,为什么都要等这么久?

上周,AIGC 的变化让世界变得疯狂,每天醒来都可能是一个「新世界」。

但从另一个角度上来说,无论 AIGC 如何智能和颠覆,我们仍然处于「旧世界」,或者准确的说,应该是「候补」世界。

不止是新 Bing,Github Copilot X,ChatGPT 的插件,Midjourney V5,以及 Adobe 的 Firefly,甚至是百度的文心一言,在你体验之前,都需要加入 Waitlist 名单进行排队等待名额。这个过程,像极了计划经济的配给制。

随着 AIGC 的服务越多,也包括原有的像是 GPT-4、Midjourney V5 的升级,Waitlist 的时间仿佛被延长。

▲ Midjourney V5

直到如今,仍然有相当多人还存在于新 Bing 的 Waitlist 之内,更别说其他更新的生成式 AI 体验。

或许是对 Waitlist 这个潜规则的无声反抗,有人做了一个「一键进行所有排队」的网站。

不过讽刺的是,「一键加入」的功能还未做好,需要先加入 Waitlist 等待,且网站域名后缀是 wtf,怨气拉满。

候补名单的背后是为了更稳的服务

当我把这个问题丢给 Bing,Bing 从 OpenAI 官方网站的三个也面里找到了四个原因。

- 限制用户数量,保证服务质量和稳定性。

- 收集用户反馈,改进服务功能和体验。

- 增加用户期待和参与感,提高服务知名度和口碑。

- 筛选出符合目标人群的用户,提高服务转化率和留存率。

而这也更像是 OpenAI、微软、Google 等大公司针对无限期 Wait 的一些官方话术。

相对来说,最先走入大众的 ChatGPT,随着模型的升级,以及大幅度降价,ChatGPT 的服务也出现过不少的波动。

吞过问答记录,宕过机,以及问答列表的混乱等等稳定性问题。

而基于 OpenAI 的新 Bing 同样也出现过过激的言辞,一直到现在,微软也在限制新 Bing 的对话次数与长度。

你可以说,限制使用 ChatGPT 和新 Bing 的人数,能够提供更稳定和快速的响应和内容生成。

但要知道这些功能和服务,已经消耗了相当的资源,几乎占用了微软 Azure 一半的算力。

目前,AIGC 还尚未迎来超级 App,仍然处于一个快速迭代的过程,甚至也可以说仍然是一个 Beta 测试版本。

通过传统的对话框与 AI 进行交互,其实是与 2023 年人手一部智能手机的状况不太相匹配。

AIGC 现在只能算是一个功能,而即将推出的 Copilot、Firefly 等才更像是个产品。

▲ Office 365 的 Copilot 功能

但它们仍然还未向外开放,躺在一个个 Waitlist 里。

从某方面来说,微软、Google、Adobe 还在「打磨」自己的产品,而从另一个方向来看,想要对所有人敞开大门,或者说 AI 成为每个人的 Copilot,还需要突破一些「瓶颈」。

蓬勃发展的 AIGC,或许开始触及瓶颈

这里的「瓶颈」,并非是外在表现的,生成式 AI 所遇到的伦理、法律法规或者说其响应的准确度。

反而是 AI 背后提供算力的硬件,以及各种用于训练的云算力。

微软正持续在 OpenAI 上大手笔的投入,先后投入几十亿美元,也逐步出现了基于 GPT-4 的新 bing,和后续还在 Waitlist 上的新 Office。

同时,为了保证新 bing,以及后续具有 Copilot 功能的新 Office 能够稳定快速的响应。

微软也提供和预留了其 Azure 云服务的一半算力和运算容量。

如此也导致了微软内部 Azure 算力资源的紧张。The Information 就采访了微软内部员工,针对于有限的硬件运算资源,微软正在实行内部硬件 Waitlist 制度。

微软内部其他开发机器学习模型的团队和部门,想要调用 Azure 的 AI 云服务,需要逐级审批报备,并最终由一位副总裁来定夺。

就如同我们在排队体验新的生成式 AI 服务,除了新 bing 和新 Office 和 OpenAI 服务外,微软其他部门也在等待多余的 Azure 云算力。

只是,随着微软 All in OpenAI 的策略,Azure 云相关算力和容量也显得十分紧张。

除了内部调用外,Azure 也提供了各种产品和服务,包括 AI、计算、容器、混合云、物联网等。

作为云服务供应商 Azure 目前扩展到全球 60 多个区域,其对外服务器产品和云服务收入占到微软总营收的 36%。

但与微软内部团队类似,购买 Azure 的客户也受到了算力受限的影响,尤其是想要调用 Azure OpenAI 依旧需要加入 Waitlist。

大概从 2022 年底,微软就打算增加更多的硬件(GPU 或者 TPU)来扩充更多的算力。

并且也与英伟达达成协议,为 Azure 增加数万个 H100 GPU 计算卡,为后续 OpenAI 提供更高的 AI 训练和推理效率。

不过,目前微软与英伟达并未透露在 Azure 当中 H100 的部署情况,微软内部也只有一小部分团队拥有 H100 的调用权限(大概率是新 bing 和 Office),大部分的部门仍然被排除在外。

一块 H100 大概的售价可能在 24 万元上下,以此为参考的话,微软为 Azure 扩容则需要投入数亿资金。

不止是微软,Google、甲骨文这些云服务商,也在大力投入 GPU 等硬件为自己的云服务扩容,准备在 AIGC 彻底爆发之前,做好算力上的准备。

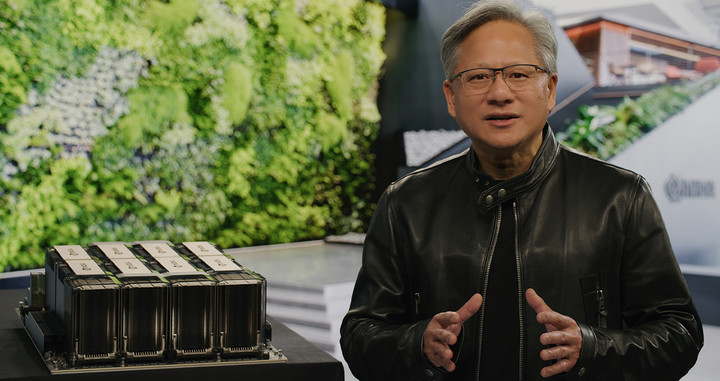

▲ 英伟达 CEO 黄仁勋与 OpenAI 联合创始人兼首席科学家 Ilya Sutskever

但从 GTC 2022 发布到现在,英伟达并没有对外公布 H100 的供应和销售情况,微软对于 Azure 的扩容计划是否成效也不得而知。

而在今年的 GTC 2023 中,英伟达并没有带来关于 H100、A100 硬件上的进展,而是一直在强调英伟达在云计算硬件上的优势。

并且其首席技术官也开始强调,「加密货币对于社会没有任何有益的贡献」,也从侧面开始强调 AIGC 领域将会是英伟达接下来 30 多年所专注的领域。

随着 AIGC 领域的持续迭代,大概从 2022 年 10 月份,英伟达的股票也随之增长,一扫此前因为加密货币衰退而导致的业务下滑颓势。

目前,英伟达的市值又达到了一个高点,几乎等同于 Intel、AMD、ARM 这三家市值之和。

但如此的高市值,似乎并没有改善硬件的供应状况,反而随着 Google、微软等大企业不计成本资源地对云计算硬件投入,按照此前英伟达的供应状况,很可能再次出现工业显卡慌的一个局面。

不止是硬件供应状况,这些高性能 GPU 组成的计算矩阵也有着很高的功率,单张 SXM 接口的 H100 计算卡功率就达到了 700W。

用于 AI 模型训练和大数据处理的计算中心的耗电量实际上也十分惊人。

在 2021 年,加州大学的 David Patterson、Joseph Gonzalez 通过研究表明,训练 GPT-3 大概需要耗费 1.287 千兆瓦时的电力,它相当于 120 个美国家庭一年的用电量。

同时,这篇论文还发现,训练 GPT-3 会产生 502 吨的碳排放,等同于 110 辆汽车的一年排放量。

他们也强调这只是一个模型的训练成本,随着它涌入市场,也会产生更多的资源消耗,可能要比训练成本还高。

OpenAI 的 GPT-3 实用了 1750 亿个参数或者变量,而 GPT-4 的参数预计在 1750 亿到 2800 亿之间。对于能耗,云计算的需求只增不减。

为此,OpenAI CEO Sam Altman 在接受 The Verge 采访时表示,OpenAI 正在寻找有效的方法来提升模型的性能和安全性。

换句话说,OpenAI 也在试图通过更高效的算法来寻找节省训练运行模型的硬件、电力资源。

Waitlist 的机制,从浅层次来看,它确保了当前 AIGC 的使用体验,以及相关服务的响应速度。

但从深层次来看,它也是一场资源角力,是 GPU、TPU 为核心的云计算中心算力和容量的互相角力,也是宏观上高投入高能耗的一场竞争。

而到目前为止,AIGC 其实仍处于一个「盲盒」阶段,对于资源的需求和占用也尚不明朗。

不过,站在各种 AI 服务的 Waitlist 队列里,确实很像在科幻电影里人们正不断排队进入 AI 控制的工厂,为其运行提供所需的资源。

Waitlist,即是虚拟世界里的候补名单,也可能是将来现实世界当中的一则为 AI 服务的队列。