苹果今年最大的更新要来了,AI Siri 的终极形态比 GPT-4o 更科幻 | WWDC24 前瞻

Siri 已经落后了。

据《纽约报道》,这就是去年苹果软件主管 Craig Federighi 和机器学习高管 John Giannandrea 花了几周测试 ChatGPT 后的想法,因此,他们决定对这个 13 岁的语音助手进行大改造。

离 WWDC 开发者大会还有不到半个月的时间,科技记者 Mark Gurman 带来了 AI 版 Siri 的最新进展爆料,看起来,这个总是被吐槽「人工智障」的语音助手确实将迎来大更新。

一个坏消息:里面一些重磅功能可能不会在今年到来。

尽管如此, Mark Gurman 称苹果内部依然将 iOS 18 视为有史以来最重要的升级。苹果 WWDC24 将于北京时间 6 月 11 日凌晨 1 点举办,届时 APPSO 将在 Apple Park 现场给大家带来最新报道,敬请关注。

姗姗来迟又未来可期的「掌控应用」功能

据报道,在 AI 的加持下,Siri 将能够进一步「掌控应用」,实现应用功能的精准控制。

比如说,让 Siri 把文件从一个文件夹转移到另一个文件夹,或者让 Siri 打开特定的新闻文章,甚至可以让 Siri 给出一个文章摘要。

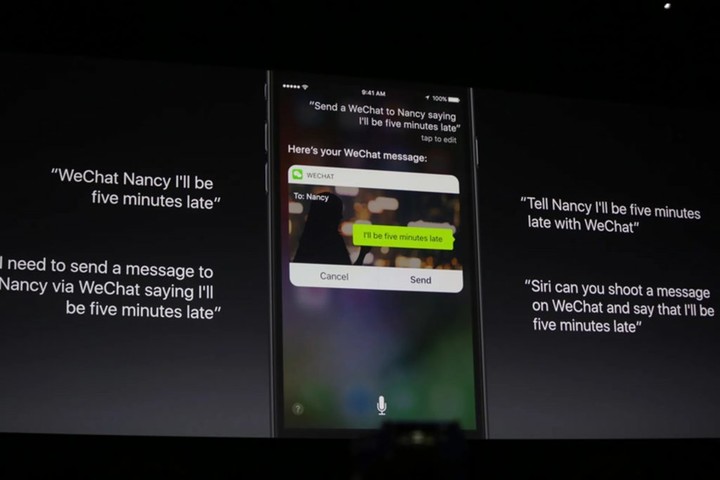

虽然现在已经能够使用 Siri 来发短信甚至发微信,但是基于 AI 大改造的 Siri 将走得更远,能够分析人们如何使用自己的设备,并学会越来越多的自动操作。苹果计划,将在其开发的 app 中支持「数百个」的命令。

▲ iOS 10 就已经能实现的 Siri 发微信功能

听着确实不错,不过 Gurman 表示,这个功能一开始仅限于苹果自己开发的 app,而且不会在今年推出,可能最早要等到明年的 iOS 18 后续更新。

并且也有消息称,旧型号或许仅有搭载 A17 Pro iPhone 15 Pro,以及 M1 以上的 Mac 能够支持更多本地 AI 功能。

新的 Siri 一开始可能一次只能听懂并执行一个命令,但有望在未来支持一串的命令,比如说将录制好的会议录音生成一个总结(也是 iOS 18 有望推出的功能),然后用邮件发给同事,还能直接补充一点文字说明,一套操作一句话就能交给 Siri 完成。

新的 Siri 也预计会和 iOS 18 的其他 AI 功能一样,存在一个判断系统,根据所需算力大小,判断 AI 任务是否可以在设备本地完成,还是需要在云端运行。

如果要去总结 Siri 目前这 13 年的发展,「管生不管养」恐怕是最贴切的一个。

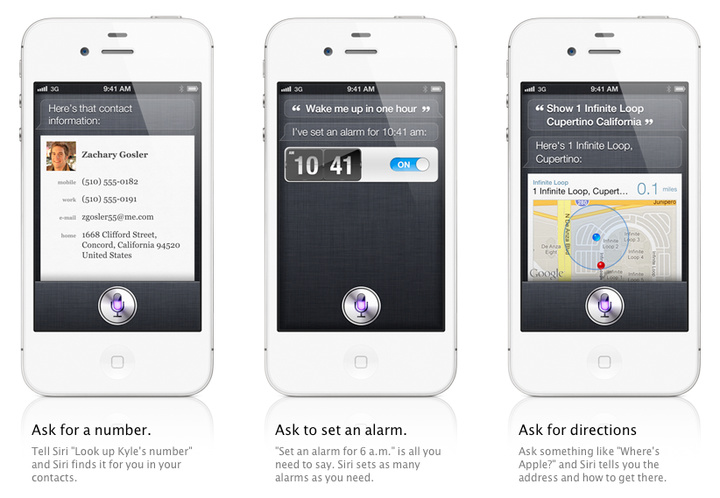

在 2011 年的 iPhone 4s 发布会上,Siri 压轴登场,给在场观众和世人不小震撼。当时对 Siri 的演示是这样的:可以问它某城市天气如何,或者某股票表现如何,而一句话就能设定一个离开公司自动弹出的提醒事项,在当时也是一个非常酷非常未来的功能。

结果,13 年过去,上面的功能似乎还是 Siri 使用最多的几个场景,就算是后来支持的家居操控,和快捷指令,总体上还是一些打开关闭的功能,其实 Siri 一直没迎来质的飞跃。

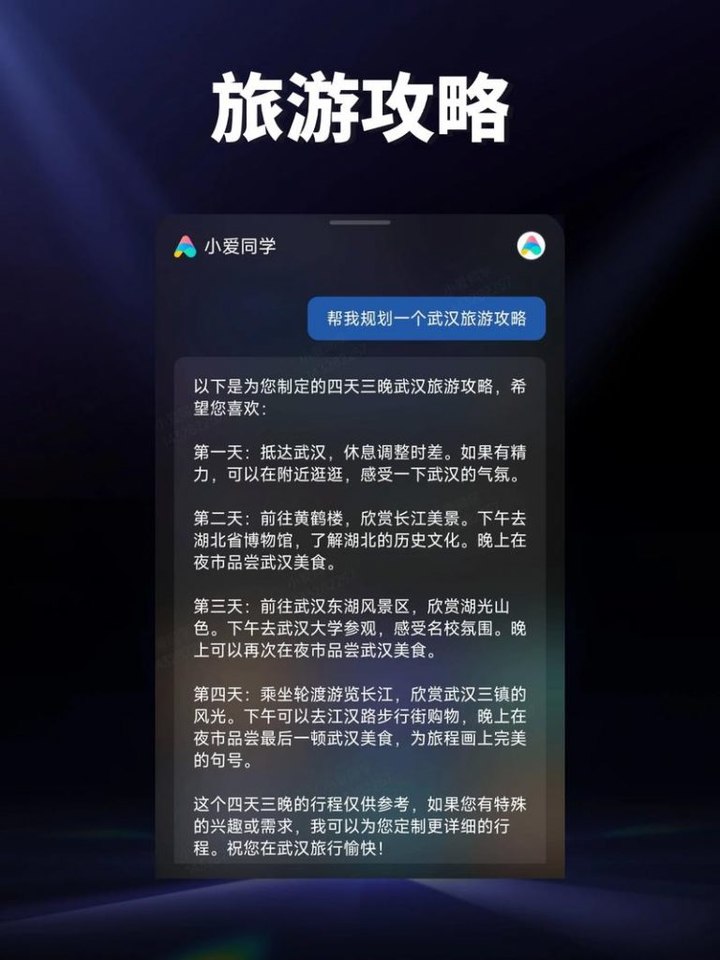

即使在面对 Google Assistant、微软 Cortana、三星 Bixby 等其他后来居上的语音助手挑战,甚至国内小米「小爱同学」也越来越好用的情况下,苹果依然不思进取,直到 ChatGPT 横空出世才意识到 Siri 已经落后时代。

▲ 小爱同学已经在去年接入了大模型

虽然苹果好像隔三差五就在发布会上介绍,Siri 又变强了,能理解更多指令了,能干更多事情了,但很多时候,能理解不代表能做到,能做到不代表能做好。

比如告诉 Siri,我想自拍,Siri 二话不说帮你打开相机和前置摄像头,然后就没有然后了,用户还需要伸手去点击快门。甚至有的时候,Siri 只会自动跳转相机应用,而不会跳转到前置模式。

如果是三星的 Bixby 助手,会自动进入自拍的倒计时,全程真正做到不需要用户动手操作。

苹果默认的相机应用本身自带倒计时功能,因此这种流程在实现上根本不需要太多 AI 因素加持,但苹果就是没有把体验做好。

Siri 的对手是快捷指令

不知道你有没有使用过「快捷指令」这个功能呢?

苹果收购 Workflow 公司后,在 iOS 12 中将其产品作为「快捷指令」整合入 iPhone,也在 macOS 12 时在 Mac 平台上推出。

▲ 快捷指令已经整合进入了苹果生态链中

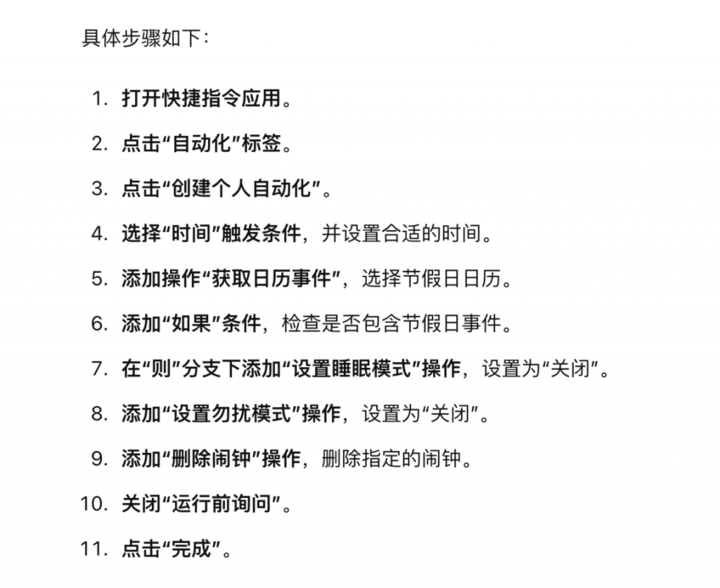

这个功能能够实现很多 iOS 的进阶玩法,比如说一键实现钉钉打卡,一键将 LivePhoto 和视频制作成 GIF,甚至还能自动化运行,实现「节假日自动关闹钟」。

但这个功能对小白用户并不友好。想要新建一个快捷指令,用户要在一个类似脚本编程的界面中选择各种操作模块,并用各种诸如「如果..那么」「只要…就」的逻辑将其串联起来,像是「节假日闹钟」这种包含多种逻辑判断和自动化运行的快捷指令,用户即使是对着教程设置,也很容易出错。

苹果虽然提供一个可以直接获取现成脚本的「快捷指令中心」,但是里面提供的快捷指令效果简单,很少有切中用户痛点的功能。

这个功能类似三星 Galaxy 手机的「Good Lock」模块,提供效果非常强大的自定义功能,但是门槛相对应也不低。

而 AI 大模型最重要的能力之一,就是自然语言的理解和逻辑思维能力。也就是说,用户对大模型 AI 说一句「我下班了,帮我打卡」,AI 就会知道你的意思是执行「打开钉钉」-「进行打卡」的操作,而不是表示自己「没听明白」。

现在的 Siri 也不是完全不具备这种能力。让 Siri 在你离开公司时提醒你给家人买个生日蛋糕,是 iPhone 4s 发布会上就被演示的功能,背后同样是理解用户语言并转化成相关操作的一个过程。

▲ Siri 发布会上介绍的很多功能依旧是现在 Siri 的主要能力

而 AI 大模型加持后的 Siri 能做到的应该远远不仅如此。用户用自然语言描述自己的复杂需求,Siri 听懂后,转化成脚本的逻辑,并自己执行相应的步骤,不用让用户面对复杂的编程,这才是真正的「快捷」指令。

▲ChatGPT 教我如何用 iOS 快捷指令设置节假日闹钟,虽然逻辑清晰,但似乎不太可用

除了让用户更自然自定义操作,还可以去期待 Siri 成为一个更「主动」的助理。

如果你使用 iPhone 时间够长,会发现在有时候,iPhone 会自动弹出建议。比如说,用户戴好蓝牙耳机,就推荐你打开网易云音乐,因为这就是你的使用规律;或者在深夜充电时,手机自动降低了充电功率,以保养电池,但又能在你醒来前充好,也是因为发现你有在睡前长时间充电的习惯。

这些就是机器学习的结果,也是苹果一直以来致力的 AI 功能。现代人一天要花不少时间在手机上,用手机买买买、吃饭、办公已经很普遍,手机自然成为比肚里的蛔虫更懂你的存在。

想象一下苹果强大的情景感知,加上更强大的手机自动操作能力,AI 版的 Siri 或许真的能化身成一个真正的「私人助理」,在你把事情交给它完成之前,就预判好你的需求,把一切安排妥当。

比如说,通过你订的机票,自动帮你查询好目的地到达后的天气,还提前设好闹钟,根据你的出行习惯和实时交通状况,预计好出行的时间提前帮你叫车,到了机场自动弹出机票和自行使用应用值机,到了当地给你打开大众点评推荐餐厅,简直是私人助理+导游。

想要实现这一套行云流水的操作,我们当然会去想,这需要也开发者和苹果的双向奔赴。不过,AI 发展的速度已经超出了我们的想象,也许未来,AI 能够直接模仿人类的操作。

我们能看懂的 UI,AI 也在学习中

虽然新的 Siri 的智能操作初期只支持苹果自己的应用,但我更愿意相信这只是苹果 AI Siri 路线的起点或者中段,而并非终点。

我相信苹果 AI 最终的目标是实现这样的场景:早上起床,用一句「Siri」唤醒 Siri,再让它打开微信公众号「爱范儿」,朗读最新的文章,就这样在完全不用动手的情况下,听取爱范儿的早报。

▲ 一个许多年前的 iPhone 概念手机壳,想法是「Siri」拟人化和语音解放双手

「快捷指令」能够支持第三方 app 的操作,主要是因为苹果开放了 API,第三方应用厂商也可以将应用内的操作拆分成快捷指令能够执行的模块。

但这还要看应用厂商是否愿意提供相关的模块和操作,比如说,如果菜鸟 app 不开放显示取件码的操作,就算 Siri 再聪明,也无法自行打开菜鸟显示取件码。

如果再进一步,让 AI 直接能理解什么是取件码,以及取件码在 app 的哪个位置,并在接到指令后自己打开呢?

这听起来好像有点太科幻,不过,行业已经在进行相关尝试了。

在上星期的微软 Build 2024 开发者大会上,微软整了个活:GPT-4o 支持的 Copliot,能够实时查看屏幕上的内容,引导玩家一起玩《我的世界》。

演示中,Copilot 用非常流畅自然、甚至还带有一丝情绪的语言,引导玩家在游戏中制作一把剑。在这个过程中,Copilot 能够识别游戏背包内的物品,还能告知玩家缺少的材料,完全就像一个带你玩游戏的「大神」。

这表明,AI 助手已经不仅仅是「你问我答」的文字机器人,或者只能够在后台编程处理数据,而是真正能开始理解我们人类看见的 UI 界面,还能知晓我们如何操作。

而今年火了一段时间的「AI 硬件」Rabbit R1,基本抛弃了操作界面,完全通过 AI 语音助手完成各种服务的使用,Rabbit 公司宣称,他们使用了一种名为「大动作模型」(LAM)的 AI 模型技术,能够在理解了用户的指令后,在服务器模仿人类的操作,直接在相关网页和应用中完成用户的指令。

▲ Rabbit R1 号称用语音来实现跨应用跨平台的操作

虽然 Rabbit R1 的表现与他们所描绘的场景相差甚远,但是这个愿景本身非常美好,GPT-4o 等机器人在视觉理解的优秀表现,也让人感觉让 AI 代替人类实现操作的未来确实不远了。

苹果作为一家在开发者中极具号召力的公司,完全可以不用模仿初创公司 Rabbit 全盘使用「LAM」的做法,可以通过开放相关接口和提供 SDK 的做法,让各大第三方开发商在应用中原生支持 AI 操作,带来更加成熟稳定的语音操作体验。

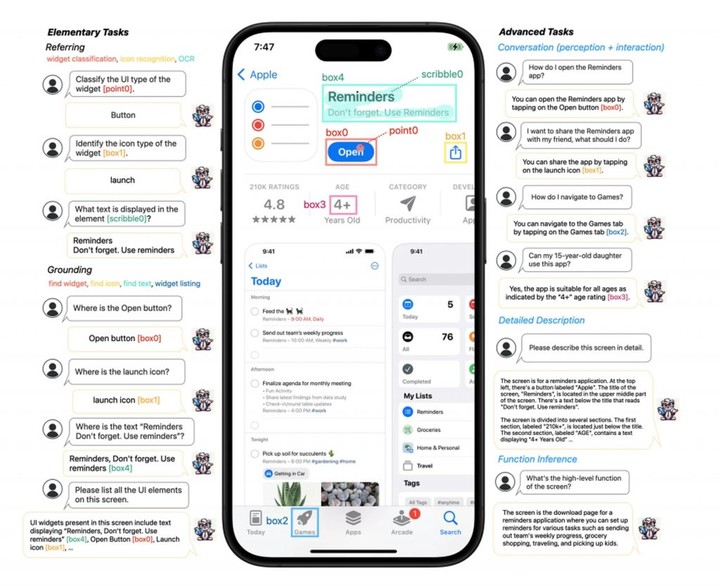

苹果相关的研究显示,他们确实有这种想法,配套苹果的应用 UI 设计标准,Siri 能够更容易理解 iPhone 屏幕上的一切。

▲ 苹果也在研究怎么让大模型看懂 UI

虽然技术不如人,但苹果在用户数量和生态构建上的领先,能成为一种非常强大的优势。

9to5Mac 这样预测和评价苹果即将到来的 Siri 和 AI 更新:

在 WWDC 上。我们或许不会看到任何特别革命性的东西,但 AI 融入数百万人每天使用的系统和应用本身就是一场革命。

比起 Rabbit R1 这种新潮硬件,人人都有的智能手机或许才是 AI 的最佳载体。

用户不需要知道自己在用的是 AI 功能,但是当他让 Siri 帮忙规划一个旅游计划、帮订机票的时候,AI 已经在开始深刻改变他的生活。