马斯克新 AI 破解千年难题却被紧急喊停?这个「玩笑」怎么让 AI 圈一夜未眠

Grok-3 证明了「黎曼猜想」了?

xAI 研究员 Hieu Pham 周末发布的一条推文在 AI 圈掀起轩然大波,推文原话是这么说的:

Grok-3 AI 系统刚刚证明了黎曼猜想(Riemann’s hypothesis)。为了验证这一证明的正确性,我们决定暂停该系统的训练。如果证明被确认无误,我们将不再继续其训练,因为这样的AI 被认为过于智能,可能对人类构成威胁。

老规矩,先说结论,这单纯就是玩梗而已。

然而,随着推文的不断发酵,还是迅速引发了超过两百万网友的关注与讨论,甚至辐射到海内外的 AI 舆论圈。

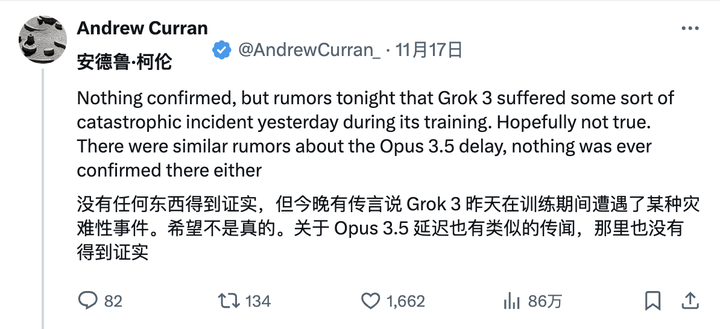

事情的源头大概要追溯到网友 Andrew Curran 更早些时候的一则「爆料」,其声称 Grok-3 在训练过程中发生了灾难性事件。

随后,各种离奇的传言纷至沓来。

网友起哄说,OpenAI CEO Sam Altman 用巨大的激光器对准了 xAI 的最大训练集群,导致数据严重损坏;也有人煞有介事地暗示有人蓄意破坏下一代 LLM 训练运行。

更有调侃称,AI 似乎获得了自我意识,并解决了黎曼猜想,但在证明代码中「故意省略了15个分号」,使人类无法验证。

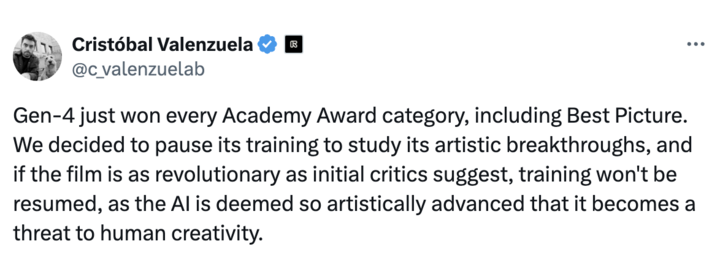

连 Runway 创始人 Cristóbal Valenzuela 也来凑热闹:

Gen-4 刚刚荣获了包括最佳影片在内的所有奥斯卡奖项。为了深入研究其在艺术领域的创新成果,我们决定暂停对其进行的训练。如果这部电影确实如早期评论家所言具有革命性,我们将不会恢复训练,因为这表明 AI 在艺术方面已经达到如此高的水平,以至于可能威胁到人类的创造力。

谣言就这么越传越邪乎。

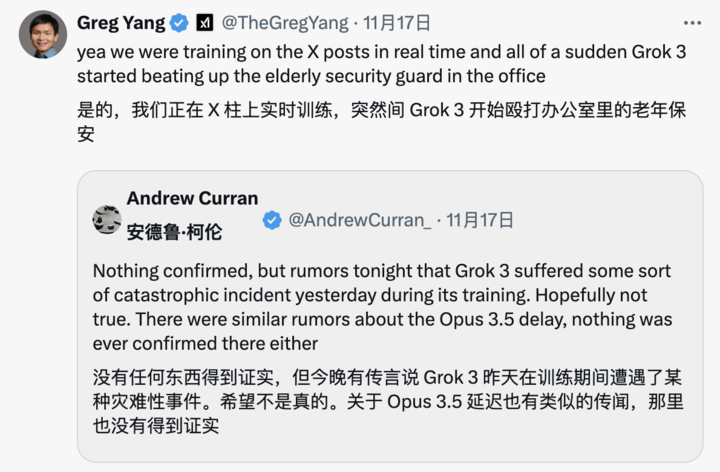

多位 xAI 研究人员也纷纷转发 Andrew Curran 推文,加入这场集体「大团建」。

比如我们的老熟人 xAI 联创 Greg Yang 率先调侃道,Grok-3 在训练过程中突然殴打办公室里年长的保安。

另一位研究人员 Heinrich Kuttler 则表示:「是的,情况非常糟糕!我们后来用nan(Not a Number,非数)把所有异常的权重都替换了一遍,才恢复。」

当然,更理性的网友直接在 X 上询问当前版本的 Grok 对黎曼猜想的理解,不出所料, Grok 的表现十分「玛卡巴卡」。

最终,这场闹剧由始作俑者——xAI 研究员Hieu Pham亲自画上句号:

好的,《周六夜现场》结束了。至于为什么证明黎曼假设是危险的,我强烈推荐马特·海格(@matthaig1)的精彩小说《人类》。

那么问题来了,为什么这则 Grok-3 证明黎曼猜想的消息能引起广泛的关注呢?首先是黎曼猜想本身的重要性。

黎曼猜想(Riemann Hypothesis)是数学中一个关于素数分布的重要猜想,由德国数学家伯恩哈德·黎曼于 1859 年提出,该猜想被列为克雷数学研究所(Clay Mathematics Institute)的「千年难题」之一。

它涉及到黎曼ζ函数(Riemann zeta function),这个函数定义为:

ζ(s)=1+12s+13s+14s+⋯\zeta(s) = 1 + \frac{1}{2^s} + \frac{1}{3^s} + \frac{1}{4^s} + \cdotsζ(s)=1+2s1+3s1+4s1+⋯

黎曼猜想的核心内容是:所有非平凡的黎曼ζ函数零点的实部都等于1/2。换句话说,如果 ss 是黎曼ζ函数的一个非平凡零点,即 ζ(s)=0ζ(s)=0,那么其实部必定是 ℜ(s)=1/2ℜ(s)=1/2。

克雷数学研究所说了,如果有人能够成功证明黎曼猜想,将奖励 100 万美元的奖金。但这个猜想至今没有被证明或反驳,也被广泛认为是现代数论中的一个未解之谜。

这个猜想的证明对于数论(数学的一个分支)有着深远的影响。

目前,很多现代加密技术(比如保护网上支付、数据隐私等)都依赖于素数的性质。证明黎曼猜想或将会让人类更好地理解这些技术的基础,并且可能影响到未来的安全算法。

假如 Grok-3 能证明黎曼猜想,这不仅将推动理论数学、物理学、密码学等领域的大幅进展,同时将标志着 AI 在推理和解决复杂问题方面的巨大进步。

甚至可以说,这将成为人工智能超越人类智能的一个标志性事件。

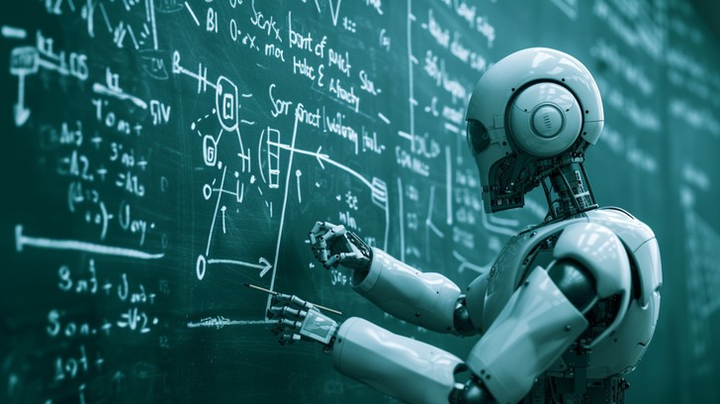

月之暗面创始人杨植麟曾表示,数学场景是锻炼 AI 思考能力最理想的场景。

数学是一个极其严谨的逻辑体系,而 AI 的推理能力往往建立在严密的逻辑推导之上。

AI 解决数学问题的过程实质上是一个持续思考的历程,在这个过程中,它会不断尝试不同思路,通过反复试错来寻找正确答案。即便计算过程中出现错误,AI 也能通过验证和校对来纠正结果。

类似的理念也体现在 OpenAI o1 的强化学习训练上。

如果说以前的大模型是学习数据,o1 更像在学习思维。就像我们解题,不仅要写出答案,也要写出推理过程。一道题目可以死记硬背,但学会了推理,才能举一反三。

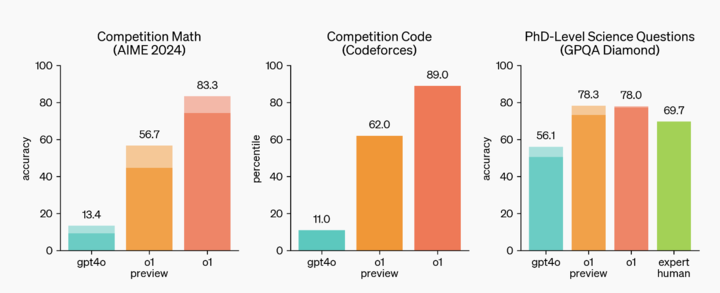

所以在今年美国针对优秀高中生的 AIME 测验当中,GPT-4o 仅完成了百分之十三的题目。相比之下,o1 的正确率高达 83 个百分点。

就博士水准的 GPQA Diamond 科研测评而言,GPT-4o 获得了 56.1% 的成绩,而 o1 的表现更为出色。不仅胜过了人类博士的 69.7%,更是达到了 78% 的正确率。

在国际信息学奥赛(IOI)的评测中,当每道题允许 50 次尝试时,模型达到了 49% 的得分率,即 213 分,而当每题提交机会增至一万次时,其最终得分提升至 362 分。

拿打败围棋世界冠军的 AlphaGo 类比,就更加容易理解了。

AlphaGo 就是通过强化学习训练的,先使用大量人类棋谱进行监督学习,然后与自己对弈,每局对弈根据输赢得到奖励或者惩罚,不断提升棋艺,甚至掌握人类棋手想不到的方法。

o1 和 AlphaGo 有相似之处,不过 AlphaGo 只能下围棋,o1 则是一个通用的大语言模型。

o1 学习的材料,可能是数学题库、高质量的代码等,然后 o1 被训练生成解题的思维链,并在奖励或惩罚的机制下,生成和优化自己的思维链,不断提高推理的能力。

这其实也解释了,为什么 OpenAI 强调 o1 的数学、代码能力强,因为对错比较容易验证,强化学习机制能够提供明确的反馈,从而提升模型的性能。

当然,更重要的是如何将这种推理能力拓展应用到更广泛的领域中。

所以我们会看到不少海外网友为 Grok-3 证明黎曼猜想欢呼,「如果是这样的话,我们真的在见证一个巨大的突破。」

马斯克曾多次在公开场合渲染 Grok-3 的强大,他声称 Grok-3 预计在年底前问世,并将成为「世界上最强大的 AI」。

实际上,Grok-3 是由上面提到的 AI 初创公司 xAI 开发的第三代大型语言模型,并预计在性能上预期将超越现有的所有 AI 大模型。

原因在于 Grok-3 训练背后依托的是目前世界上最大的 AI 训练集群——Colossus。

这个集群由 10 万个液冷英伟达 H100 GPU 组成,采用单一的 RDMA 网络互连架构。这个集群的规模已经超越了目前世界上任何其他的超级计算机,而且未来还将持续扩充 GPU 数量。

根据 The Information 的报道,Colossus 的出现甚至引起了 Altman 的密切关注,后者派飞机飞越 Colossus 训练基地,试图窥探其开发进展和能源供应情况。

所以说,当「最强 AI」、「千年数学难题」和以及长盛不衰的「AI 威胁论」这三重元素叠加,一场完美的「谣言风暴」就此形成。

甚至我们可以认为,Grok-3 证明黎曼猜想的谣言,与其说是一场闹剧,不如说是整个 AI 行业的一面照妖镜:

其一是折射出人们对 AI 的深层态度,大量技术乐观派坚信 AI 终将无所不能,既担心它发展得太快会失控,又害怕它发展得不够快无法实现突破。

其二是自 GPT-4 问世以来,尽管 AI 领域不断有新产品涌现,却鲜有真正的突破性进展。

人类既是 AI 的创造者,却又成了它最焦虑的观众。

每一个 AI 谣言的背后,都藏着整个行业的焦虑与期待。

加之最近闹得沸沸扬扬的 Scaling Law 发展撞墙论,相比去年的井喷期,今年的「创新疲劳」让人们对模型的小步改进已然失去耐心。

在这个意义上,Grok-3 证明黎曼猜想的谣言也成了人们对未来的一次集体想象。哪怕作为普通用户,我们也越来越期待下一个从 GPT-3.5 到 GPT-4 的质变时刻。

当然,真正的 AI 突破,往往发生在所有人都不看好的时候。

但我们都希望这个谜底能在年底前揭开。