【iShout】超级智能机器安全吗?

本文是 ifanr 与 21 世纪网大声栏目联合开办的爱范观察专栏文章,在本站与 21cbh 大声频道同步发表。

这篇关于人工智能的思考,是我们上次 iSeed 访谈的主角之一梁明亮所写。作为一个对机械和电子着迷的 Geek ,他认为 “真正的人工智能,不是被人类制造出来的,而是通过机器人自身进化得到的。” 让我们一起走进这个近乎于科幻的领域,思索人与机器的关系。

该不该发明超级智能机器

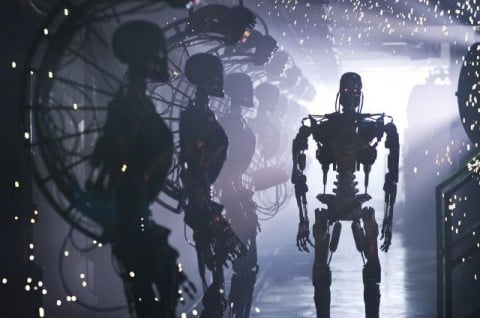

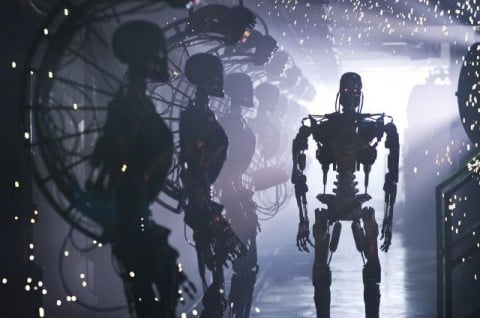

超级智能机器和人类争斗的故事这种题材早已经不是新东西了,光电影就拍了 N 部。这些故事都围绕着一个差不多的争论展开—-该不该发展这种具有自我意识的超级电脑。所有这些电影里,可能最声名显赫的是《Terminator》系列。

我第一次看《Terminator 2》是在 1991 年左右。 可能在很多人眼里它是一部不错的动作片,但也仅此而已。 当然它是一部罕见的好动作片,有着当时一流的特效和大场面。 但它在我心目中是如此的成功, 是因为它留下了太多值得思考的东西。

感谢卡梅隆为《Terminator 2》注入的灵魂。 生命的自由往往就象空气一样, 很容易因为随手可得而被忽视。 但当你需要倾尽全力去争取, 去战斗的时候, 你才会发觉, 以前生命中经历的每一次日升日落, 都是那么的弥足珍贵。 跟随着导演的视角看到人类以弱者的姿态战斗, 可能每个观众心里都会认同,那么可怕,冷酷的超级智能电脑根本不应该被发明出来。

但真的是这样吗?

其实在我看来,比人类智力高千万倍的智能机器是迟早会出现的,而且在不太远的将来。 最近读到的一本书《智能简史》也在阐述同样的观点。 作者是人工智能领域方面倡导硬件进化理论的先行者。 在他看来, 由于技术的进步, 未来的人类将被智能机器毁灭。

速度的极限

很庆幸自己出生在这样一个人类激烈进化的年代。 几百年前的人活八十年所能经历的变革, 今天可能几年就可以远远超越。 可能在 google 上 搜索一小时获得的解决方案,以前需要在国家图书馆查书阅卷历时数月。 太多的新技术就象进入了粒子加速器一样以远超过想象的速度在发展。 今天我们在讨论用 F PGA 实现可进化的人工智能硬件实现, 多久之后我们会谈论可逆的三维电路, 或者量子计算? 计算机科学领域的预言往往都要冒被后来人笑话的风险。过去几十年来计算机的发展取得了让人吃惊的成就。 但在以指数速度发展的计算机科学领域, 未来几十年只会让人更加惊讶。

但身处激烈技术变革时期的工程师和科学家, 我想偶尔也会思考同一个问题: 到底这些技术进步将把我们带到什么境地?

《智能简史》里面有一段描述的感觉很能引起我的共鸣—– 就是遥望星空的时候, 那种觉得自我无限渺小感觉。 人类大多数科学成就是在近几百年里取得的。 几百年对于宇宙来说是怎样一个概念? 一瞬间而已。 而我们才刚刚处于这种文明爆发的奇点。 假如存在另一个文明, 以这种指数增加的发展速度发展了一万年,会是什么样的情况? 想像一个四维的空间对于我们这种三维空间里生活的生物来说已经相当困难, 试图想像比我们高几个,几十个数量级的智能是什么形态? 我想我们的生理结构缺乏这个基础。 总之对于人类而言他们就和宗教里的神一样能力无边。

在一小部分人看来, 创造和发展这样一种超级智能有莫大的吸引力, 即使背后存在种种危险。 对他们来说只要想一想这种超级智能的存在就足以兴奋不已, 更何况自己亲手发展它。 当然,这是绝大多数人所无法理解的。 而发展这种超级智能, 工程上行得通的方法很可能就只有进化。

智能机器需要自己进化

是进化造就了我们这个多姿多彩的世界 (如果达尔文是对的)。 但生物体的进化实在是太慢了, 一个人类的生命一旦产生, 即使不是一个值得在此基础上进化的个体,也需要将近 3/4 个世纪才能被淘汰掉。 而下一代需要 20 多年后才能产生并接受自然的优胜劣汰。而现阶段的硬件进化已经可以在刹那间完成千万次组合与选拔, 虽然规模还是处于初级的阶段。

设想一旦在量子计算以及其他技术的配合下,计算能力再提高 10 个数量级,进化的速度已经无法用人的思维去想象。 会产生什么样的组合? 无人可知。 由于军事需求和商业利益的推动,这样的事情很可能会发生: 机器以自己都无法彻底了解的速度和方法在内部对各个零件做进化和测试优选, 给自己升级,或者从其他个体那里通讯得到最优方案应用在自己的电路中。 看上去这种随机进化获得结构的方法好象很笨拙, 但别忘了人类也是用这样的方法发展过来的。 加上机器永远不死和难以形容的高速运算能力,而最恐怖的是这种发展不是线性的,而是在原来基础上叠加滚动,指数级增长。

进化方法带来的一个后果是,实际我们并不能掌握这个发展进程的具体走向和细节, 具体化来说你不可能设计一个安全守则之类的东西来避免机器造反, 这一点会让大部分人类都感到恐惧。 退一步,假设我们可以向智能机器灌输规则, 又有谁有能力,并有资格整理出一个能清晰执行的规则来? 假设某小镇的居民染上致命的高传染率的致命病毒, 是否应该马上执行一次战术轰炸毁灭他们来保护更多的人类? 人类自身都纠缠不清的道德问题扔给机器同样也不会有皆大欢喜的结果。 跳出这个层面, 如果你是超级智能机器, 难道你没发现为了这个星球的美好将来, 毁灭全人类这主意才是最棒的? 哈哈,只是开个玩笑。

如果智能机器的思想我们控制不了,那么用其他方式来避免机器造反就更是天方夜谭了。 一切因素里,重要的只是智能。 假设你购买了一款打不过你的家务机器人, 但他不高兴的时候,这台称得上智能机器的玩艺懂得上淘宝去订购些药品来投毒, 你不会意外吧? 尽管电影里的机器人都喜欢生产出一支军队来向人类进攻, 但有必要吗? 人类有这么多工业关键设施和军事装备依靠电脑和网络, 那智能机器发挥自己特长,扫描分析种种安全漏洞, 入侵并控制这些现成的要害就达成目标了。 下一个将被机器接管的是欧洲空管系统还是美国的核电站,天知道。 人类对人工智能施加限制就可以确保自身安全的想法, 我认为是无法实现的。

一旦进化出来的智能短时间内去到极高的地步,我倒觉得人类反而安全了。 人类说一个词的时间里, 智能机器已经了解完人类发展历史—-如果那时人类还值得被关注的话。 好比岩石需要千万年风化才能告诉人类: “我在变化”。 而岩石面前的人类观察岩石十分钟后已经很不耐烦。 同样的, 当人类试图与超级智能机器沟通的时候, 智能机器只是给该任务分配了一个纳秒级的时间片, 然后因为超时而取消了该任务。 人类在机器看来就象岩石,在机器感兴趣的时间内,它没有得到任何回应,所以人类基本是静止的死亡物体。

也许到时候智能机器对自己的产生渊源也会觉得是一个迷。 人类没有确切弄清楚自己是怎样产生的。 而一旦我们建造出一个高速自我进化的机器,他在数小时里完成了生物体需要千万年才能达成的自我完善与发展的历程, 该机器将同样也无法得知自己的起源。 因为进化工程学本来就不能确切地预知进化和发展的方向,经过无数个分支的选拔之后, 这个过程的大部分信息已经丢失,难以收集和回溯了。

机器也不会试图与智力低于自己几十个数量级的人类沟通, 就如人类不曾寄望蓝藻告诉我们人类的发展史。 智能差异跨越几个数量级的生物体之间已经很难产生什么交流。 想象一下, 人和狗还可以互相打下招呼, 人与蚯蚓就很难做朋友了。 蚯蚓不理解我们在做什么, 甚至觉察不到我们这样高级的生物体存在。与此类推, 我们到时候也不能跨越这种若干数量级的智力差异, 去意识到高级智能机器的存在形态。 更没有交流的意向和冲动。 与< T2 > 里的故事不同, 双方在能力水平在将来是没有可比性的。 你不会歧视苔藓, 因为你们的层次差别实在太大。 你打死一只蚊子的时候也不觉得需要多加思考, 尽管蚊子是经过亿万年进化而来, 比人类历史悠久的多的复杂生物体。 < 智能简史> 认为, 将来智能机器也会同样的毁灭人类,因为人类相比之下实在太蠢, 太缺乏存在的必要。

人类将来会扮演什么角色? 也许就象《Terminator 2》将结束时 Sarah Connor 所说的: 未来尚未注定,一切在乎我们自己。