技术正在解读情绪,而商业已经等不及了

十年之后,我们可能都不会记得当初冲着一台机器人皱眉头,而它却回应你说“你不喜欢这样?”时的窘态了。

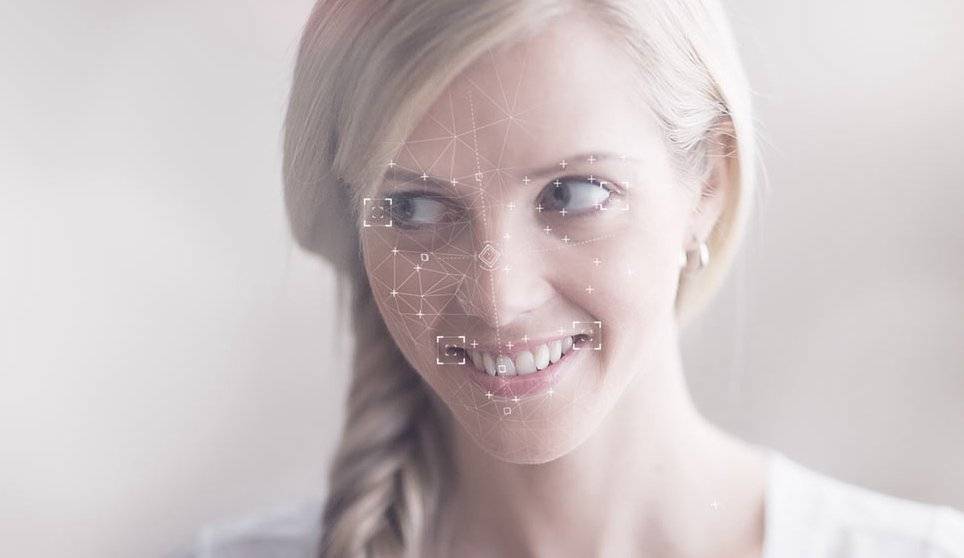

Affdex 就是这样一个机器人。它运行在 iPad 上,能够识别四种情绪——高兴、疑惑、惊讶和厌恶。Affdex 可以调用 iPad 内置摄像头扫描面部,在镜头前如果有多个人,它可以对每个人分别定位。之后再区分面部主要区域,如嘴、鼻子、眼睛和眉毛,然后进行标注,并用简单的几何图形绘制出面部的大致轮廓。同时,Affdex 通过可形变点,如嘴角,和不可形变点,如鼻尖对面部表情进行连续侦测。不可形变点起着参考坐标的作用,可以依此判断形变点的位移情况。

New Yoker 记者对这款软件试用时,Affdex 会对微笑的表情亮起绿灯,当他做出疑惑的表情时,表示疑惑的标识会立即亮起绿灯,识别速度和准确度都非常高。

别对我说谎

2014年,包括 Google、百度IDL、微软、Facebook 在内的科技巨头,以及格灵深瞳、Face++ 等初创公司因为对深度学习、机器视觉等人工智能的研究获得了很大的关注度,也取得了诸多进展。与之相比,情绪识别的研究起步要晚很多,几乎一直是机器学习的盲区。

好在情绪识别的研究正在一步步向前推进。20 世纪 90 年代以来,一批研究人员开始从事这方面的研究,试图让机器读能懂人类情绪,并可以像人类一样作出正确回应。一些智能系统已经可以对音高、音色和响度进行分析,识别出深层次语义,比如根据一位女性和孩子的对话,可以辨别出这位女性是不是一位妈妈,她是不是在盯着孩子的眼睛看,以及她是失落还是高兴。另外一些机器则可以分析人类遣词造句的方式,或者是解读肢体语言,然后判断用户的情绪。此外还有一些人选择从面部表情入手,因为在很多时候,面部承担着情绪沟通的功能,而我们通过面部表情传达的信息可能要远远多于语言本身。

Affdex 的缔造者 Affectiva 就是这样一家创业团队,创始人之一是埃及裔科学家 Rana el Kaliouby。成立于 2009 年,Affectiva 被一些商业期刊评选为成长最快的初创公司,年仅 36 的 Kaliouby 一并成为了一颗商业新星。情绪识别系统是一座待开采的金矿,这家初创公司用它的成长速度验证了这一点。在 Kaliouby 眼里,这一切都是顺理成章的事情,而在不久之后,也许五到十年的时间,情绪识别系统将会无处不在。

Affectiva 的团队成员大多来自 MIT,Kaliouby 本人则拥有着计算机科学博士的头衔,精于数学概念和理论,贝叶斯概率和隐马尔可夫模型都不在话下。近日,New Yorker 记者对 Affectiva 进行了深入报道。

和这个领域的其他公司如 Emotient,Realeyes 以及 Sension一样, Affectiva 也是建立在 Paul Ekman 的学术研究基础之上。Ekman 是一位心理学家,他的研究始于上世纪六十年代,并构建了一套纯熟的理论体系,证明了人类的面部至少可以表达六种情绪,分别是高兴、悲伤、惊讶、恐惧、愤怒和厌恶,与性别、年龄、种族或者是文化背景无关。他将这些面部表情进一步分解,系统化为 46 种“动作单元”的排列组合,最终写入了《面部动作编码系统》(Facial Action Coding System,也称FACS)。这部著作有 500 多页之厚,全面而又细致地讲述了面部的动作。数十年来,他的理论大范围应用在学术研究、电脑动画制作、测谎和案件侦破等诸多领域。

看过美剧 Lie to Me 的一定对这段故事有印象。没错,卡尔·莱曼博士的原型就是 Ekman,剧中的主要故事便是来自于 Ekman 的经历。目前他在另外一家情绪识别企业 Emotient 的董事会任职。

当然,学界对于 Ekman 的理论有着不少的争议,主要来自于社会学家。一些社会学家认为在解读情绪时,当事人所处的情境对面部表情的解读也起着重要的作用。但机器化的情绪识别系统可以屏蔽掉环境因素的影响,进而从某个层面验证了 Ekman 的理论。通过扫描面部动作单元,系统对礼貌性微笑和发自内心的微笑,假装的疼痛和真正的疼痛的识别率已经超出了人类。

除了实时侦测表情之外,装有情绪识别系统的机器人还具有一定的预测能力。它可以不眠不休,全神贯注,不会遗漏掉任何一种表情,哪怕是当事人自己都不曾察觉的表情。比如,通过扫描微表情(micro-expressions),识别系统可以预判行政主管会不会毙掉财务预算的提案:一闪而逝的厌恶表情意味着他发现了提案中的不合理之处,而愤怒的表情则预示了这份提案被拒的命运。

解读表情,还是解读心理?

到此,你可能会怀疑,这一技术和读心术还有什么区别?

Kaliouby 一再强调这一技术只能够解读面部表情,而非心理。但事实似乎并非如此。

Affdex 系统定位于可以对人类情绪作出可靠推断的工具,捕捉人类无意识状态下的深层次信息。这一点从它潜在的客户和应用领域可一窥究竟。CBS 在其拉斯维加斯的实验室里部署了 Affdex ,用它来测试新剧的效果。在 2012 年大选之际,Kaliouby 利用这一系统跟踪监测了超过两百名观看奥巴马-罗姆尼演讲的观众,发现 Affdex 可以预测观众的投票倾向,准确率达到了 73%。

此外,Skype 的竞争对手之一, Oovoo 也在与 Affectiva 合作,将 Affdex 内置到视频聊天工具之中。

现阶段,视频会议正变得越来越普遍,但视频内容是很难被数据化的,分析起来也无从下手。

而应用 Affdex 是目前可行的途径之一,在商业谈判中,你可以知道对方没有告诉你的是什么。比如系统捕捉到了对方的假笑,这也预示着他并不买账。

除了 Kaliouby 之外,Affectiva 的另外一个创始人是她的导师,Rosalind Picard,MIT Media Lab 的专家,精通电气工程和计算机科学。她早期在 Media Lab 从事图像压缩技术的研究,但很快遭遇了技术瓶颈。当时的图像压缩技术大部分还是和图片内容分离的,处理过程中,机器并不知道一幅肖像画和一幅风景画的区别。

如果机器能够理解它所看到的内容,图像压缩技术是不是可以再次提高?

如此一来,机器需要的不再是简单的视力了,而是视觉,亦即“看见”和“看懂”之间的区别。只有具备视觉之后,机器才可以辨识图像中的内容,知道图像中哪部分是重要的,哪部分是次要的。

Picard 的灵感来自于神经器官学家 Richard Cytowic 的《品尝形状的人》。这是一本探讨通感的书,Cytowic 认为知觉的处理中心在大脑的边缘系统,这块区域同时也负责人类注意力、情绪和记忆的调控。初看,其中与 Picard 的研究相关的似乎只有注意力和记忆,而情绪似乎并不相干。

在翻阅大量神经科学的文献之后,Picard 改变了看法,情绪和理性是息息相关的,正如过多的情绪都会造成不理智,过少的情绪也是如此。丧失情绪控制能力的人同时也会丧失决策的能力,无法全面地看待事物,也不会懂得常识,这些人丢失的能力也正是 Picard 希望计算机能够拥有的。

1995 年,Picard 尝试将自己的发现写入论文,她认为情绪分析是机器学习和机器智能的必要能力,程序员在编写代码之初就应该考虑软件与人互动时的情感因素。只是这些发现并没有被重视,于是,她推掉了数百万美元的图像压缩研究资金,潜心继续研究,最终写成了《情感计算》(Affective Computing)一书,Picard 也在有意无意间开创了计算机科学的一个全新学科。

彼时的 Kaliouby 在并不成功的求职之后,已经开始攻读硕士学位,并在偶然的机会读到了 Picard 的《情感计算》,大受鼓舞,将其视为偶像的同时也决意开发出可以识别面部的算法。

开启情绪识别的大门

人类的面部是一项很高深的学问,不然玄之又玄的相面术也不会如此经久不衰。人们解开面相奥秘和解读表情上的求索之心生生不息,而与此同时,面相的个体差异又是如此之大,环境、光线、视角又同时会造成干扰。若要让机器学习完成同样的事务,在构建算法时,研究人员就需要穷尽几乎所有的可能性,其工作量之大可想而知。这一过程对机器学习能力是一项不小的考验,它需要能够在大量的数据中发现深层次规律,并将发现的规律用于解读新的数据。

Kaliouby 很快便开始组建早期的研究团队,而 Ekman 则已开始将 FACS 进行自动化,构建一套可以区分独立面部动作单元的系统。以 20 世纪 90 年代的计算水平,这项工作的难度可想而知,很大一部分工作还需要人工干预。

在就读博士学位期间, Kaliouby 的导师对情感计算并不熟悉,她自然而然也受到了一些质疑。在一次陈述研究报告的时候,一位观众表示 Kaliouby 所想赋予计算机的能力和自闭症患者的症状有些相像。于是,Kaliouby 开始研究自闭症。当时剑桥的自闭症研究中心正在进行一个庞大的项目——建立人类面部表情库,这样在外界的干预下,自闭症患者便可以进行学习。

不同于 Ekman 对面部表情进行数据化度量的研究方法,该研究中心采用的是面部画像的方式,更加自然也便于学习,比如,在“思考”的框架之下,又细分为沉思、选择、想象、判断和思虑等不同的分类。研究中心雇佣了六名不同年龄段的男女演员,让他们在镜头前表象这些情绪,同时让20名裁判负责评定,获得多数人一直认定后才可标记为一种情绪。至项目结束,标记的情绪数量达到 412 种。

在 Kaliouby 看来,人类面部表情数据库是机器学习的最佳内容。于是,她创立了 MindReader 系统,可以在半实验室环境下辨别多种复杂的情绪。此后,她将这项技术应用在情绪辅助工具的开发上,辅助自闭症患者在合适的场景作出合适的行为,比如继续说话,转换话题等等。

正是在筹备情绪辅助工具的时候,Picard 决定拜访 Kaliouby 的实验室。两人聊得很投机,Picard 对这个项目也很看好。后面的合作也就是顺理成章的事情了。国家科学基金(NSF)也拨付了近 100 万美金用于原型机的开发。

在团队开发 MindReader 的同时,Kaliouby 将软件共享给资助企业参与测试。很快便引起一大批企业的注意,比如百事想将它用来判断消费者的喜好,美洲银行想在 ATM 机上进行测试,丰田想用它来监测司机的驾驶行为,FOX 则想用它来测试新剧目。还有诸如微软、惠普、雅马哈、本田、NASA、诺基亚等企业纷纷希望参与测试,各种各样的疑问也纷至沓来,比如某组数据的含义,比如如何将软件应用在特定的情境之中等等。

在疲于应付的同时,Kaliouby 也发现实验室的人手短缺,并不足以满足这些请求。她跟踪记录每个企业请求内容,并最终发现只有扩大场地,招募更多研究员才能满足这些需求。这一决定最终促成了 Affectiva 的诞生。

这项技术既可以服务于自闭症患者,也可以为 FOX 等公司所用,何乐而不为?在进行商业运作的同时也可以肩负起它的社会责任。

尽管 Kaliouby 表示希望专注于学术研究,但 MIT 的 Media Lab 的负责人促成了项目的企业化。

一念成佛,一念成魔

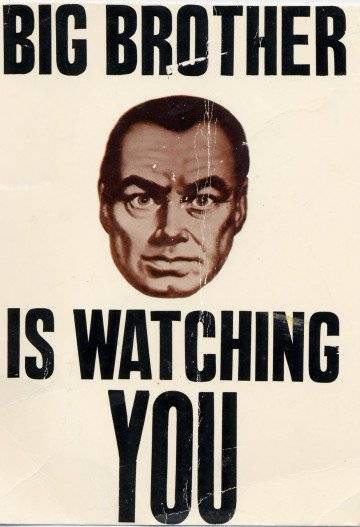

这系统能在员工不知情的情况下监视他们吗?

它可以读懂消费者的心理吗?

……

顾客的需求五花八门,这也是 Affectiva 面临的商业和道德层面的抉择。

MindReader 软件此前都是用演员进行训练的,应用到现实场景中,所有的代码都需要重写。重新调整的系统首先利用超级碗在线广告进行验证,后续则与哈佛商业学院进行合作,对 250 人的受试人群进行了更为严格的验证。

新技术在应用初期往往会面临争议,剑走偏锋的事情也时有发生。拥有如此潜力巨大的技术,Affectiva 也不例外,“双重底线”随之被动摇。聘任了职业经理人打理公司之后,Affectiva 获得了数百万美元的风险投资,与此同时,企业逐渐偏离辅助治疗领域,向市场调研的方向倾斜。

这一动荡最终导致了联合创始人之一 Picard 及其研究团队的离去。尽管如此,Affectiva 的发展势头不减,MindReader 项目得到了市场调研机构明略行(Millward Brown)的认可,用来监测观看广告的人的表情。明略行在全球六大洲拥有数十万的广告测试人员,他们打开网络摄像头,端坐在屏幕前观看广告,之后他们的情绪变化数据源源不断地汇集到 Affdex 的系统里。

随后,Affectiva 获得了明略行母公司 WPP 集团 450 万美元的投资,而 WPP 旗下拥有格雷、奥美、博雅等数家广告和公关公司,Affdex 很快便被用来测试数千条广告的投放效果。

此后,另外一个传播巨头麦肯广告也成了 Affectiva 的客户。

据 Kaliouby 表示,Affdex 已经分析了超过 200 万份视频,受试者来自全球 80 余个国家。数据量的增加使得这一系统的识别能力进一步提高。目前,Affdex 可以辨识出微笑中的细微差别,辨识能力超出大部分的人类。

2012 年,西班牙政府遭遇财务危机,不得不施行严苛的税收政策,包括对每张电影票征收 13% 的税。巴塞罗那一家喜剧俱乐部因此而流失了三分之一的客人,最后找到麦肯在西班牙的分部寻求咨询。在麦肯广告的建议下,这家俱乐部在座位上安装了和 Affdex 功能相似的软件,并将剧院免费对外开放。它承诺观众每笑一次收取 0.3 欧元,上限是 80 次。如果观众试图掩盖或在笑的次数上撒谎,就会被收取 24 欧元的全票价。这家剧院的营收也是水涨船高。

这一事件的广告效应为麦肯带来了更多的客户,同时也提高了 Affectiva 的知名度。随后一位西班牙的经济学家联系到 Kaliouby,希望利用她所拥有的技术进行更深层次的研究。

情绪经济:一个全新的经济形态

Kaliouby 的实验隐约勾勒出了未来的轮廓,而情绪识别的意义不仅仅是小小的广告技俩,也不仅仅是巧妙的避税手段,而是昭示着一个庞大恢弘的情绪经济(Emotion Economy)。

科技界的先驱预言了物联网的诞生,亦即万物互联互通,具备数字化感知能力的时代,以及在此衍生出的“环境智能”。而按照 Affectiva 的发展节奏,情绪也有可能成为其中的一环,比如在手机中植入“情绪芯片”,它就可以像 GPS 一样在后台运行,每当你拿起手机就可以记录一次情绪脉冲,如果条件允许,还可以记录你的心理。

以人平均一小时查看 12 次手机的频次来计算的话,这将是一个很大的数据,可以完整的记录人在一天甚至更久时间段中的情绪变化,在此基础上推断人的心理状态也是轻而易举的事情。

情绪经济多少有点抽象。在某种程度上,它可以看作是现存经济形态的一种延伸,目前很多互联网服务已经可以通过“神经活动”进行付费使用,听起来有些诡异。在 1996 年的著作《互联网的规则》一书中,有这样的阐述:

注意力是网络空间的硬通货。

这本书也最早认识到,数字经济的原始驱动力主要来自于新的精准营销模式。而在 2008 年,Wired 的作者 Chris Anderson 撰文分析了为什么免费将是未来的商业模式,并预言了免费经济时代的来临。

而事实上,免费经济是一种新的物物交换的经济形态。我们免费获得的一切将从新的层次上偿还:我们专注享用免费服务时,也是服务提供者用来跟踪研究行为喜好的绝佳机会。

每个人都有三种可交换物,一个是金钱,另一个是时间,第三个是注意力。

Thales Teixeira 与 Affectiva 有业务合作,他同时也是哈佛商学院的教授。他曾尝试对计算注意力的价值,发现和货币一样,注意力的价格也是浮动的。他将超级碗广告作为高端广告投放的标杆,计算出在 2010 年美国人注意力的价格是 6 美分/分钟,到了 2014 年,这一价格已经上涨了 20%,比通货膨胀还要高。

注意力价格上涨的背后反映出一个比较实际的问题,即注意力正成为一种稀缺资源,因为屏幕正变得无处不在,平均下来,每台设备对人的吸引力都在下降,毕竟人的注意力是有限的。

正如石油资源的短缺刺激着人们去开发利用新能源,正有越来越多的人投入到消费者认知(consumer cognition)的研究之中,他们寄望着在很短的时间内获得更多的关注度和注意力,并记录下这种密集程度。而情绪化的人更容易参与其中,因为情绪本身就是一种记忆的标识。所以研究已经开始偏向于“如何才能更快地触达感知到这些情绪的人?”

这种研究方向的转变很快被一些公司所利用, Affectiva 随之开发了一套动态定价广告系统,可以根据用户的反馈实时定价,并为此申请了专利。据不完全统计,情绪感知方面的专利技术多达上百项,其中大部分都和广告有关。涉及的公司则包括 A.O.L、日立、eBay、IBM、摩托罗拉和索尼等等。

相机真的可以和 Cookies 一样?

此前不久,Verizon 计划发行一款多媒体机顶盒,配置有多种传感器,包括热成像图形传感器,用于侦测体温;近红外传感器,用于测量深度;以及多阵列麦克风。通过扫描,系统可以得知用户的年龄、性别、体重、身高、头发颜色和长度、面部特征肤色、癖好、语言,甚至有没有口音都可鉴别出。它还可以辨识出宠物、家具、画像、薯片等等。结合多媒体功能,它还能探测用户的网页浏览数据,邮件内容,也可以侦测用户的情绪……

所有这些数据都可以被电视的广告投放系统利用。当你叹息时为你推送香薰蜡烛的广告,当夫妻间吵架婚姻出现裂痕时,推送律师事务所的广告,等等诸如此类。

你可能认为上面这些都是臆想出来的,要知道大部分功能在微软的 Xbox One 上已经可以实现了,它内置的相机能够以 30 帧/秒的速度追踪玩家的动作。在游戏之外,微软也在运用此类技术开发电视广告定向投放系统,Google、Comcast、Intel 等都在朝着相同的方向努力。

其中不免会触及到隐私问题。

在这一领域,Affectiva 等企业可谓是如履薄冰,他们在小心翼翼地进行着尝试,在不断试探消费者底线的同时,也在试图找到最终的解决之道,否则一不小心便会成为人见人厌的 Big Brother。

或许我们最终会习惯了摄像头常开的状态,就像存在于每个人电脑中的Cookies一样。

这是情绪识别领域的新星 Affectiva、Emotient 等企业的愿望。

与此同时,Affectiva 收到了一份颇有诱惑力的提案——通过 CCTV ,监测迪拜的幸福指数。

题图来自 Pictures2015 插图来自 Realeyes、UKsynaesthesia、Blingcheese 和 FIRSTLIGHTFORUM