打造机器鉴黄师,图普科技未来要让 10000 个唐马儒都失业 | MindStore

如果希望参与到 MindStore 栏目报道,或者有相关项目推荐,请点击我们网站顶栏 “寻求报道” 按钮填写相关资料。初创团队的产品如若想获得 MindStore 栏目的采访,请将产品提交到 MindStore.io。

前不久的人机围棋大战,最终人类顶尖棋手李世石以 1:4 不敌 Google 出品的人工智能 AlphaGo。

其核心原理采用了多层神经网络对图像进行分析,同时运用深度学习算法总结规律,最终得出战胜人类高手的棋招。

实际上这套原理还能够应用在别的领域,就比如上个星期登陆 MindTalk 线场的图普科技,每天利用人工智能对图片和视频进行超过 3 亿次的鉴别,利用计算机的能力来发掘图像信息中的价值。

目前已有数百家企业成为他们的用户,其中更是包括了七牛云存储、360、映客、今日头条、秒拍、等一系列非常知名的产品。

图像鉴别,10000 个唐马儒都干不来

互联网的开放不仅带来了自由,同样也成为垃圾信息的温床。最为人熟知的一个职位叫做“鉴黄师”,代表人物自然是“唐马儒”,但实际上“唐马儒”再多也满足不了现在对于图像鉴别和挖掘的需求。

最好的例子就是前不久爆出的“直播造人”,视频和直播类内容的兴起使得对内容的鉴定需求呈几何倍数增长。

图普科技 CEO 李明强

垃圾信息的问题在互联网的文字时代也同样存在,但相对比较好解决:不断在后台更新关键字就可以完成屏蔽。但图片和图像相对复杂的多,正如图普科技 CEO 李明强所说:

直播对于审核的实时性要求太高,同时在线的直播数量大,一不小心违规的东西就上线了。

传统的解决方案是通过人力完成,所需要的人数会与主播成一个比例。通常都是好几百人坐在屏幕前面持续对闪过的画面进行筛选,如果发现不符合规定就进行人工处理。

相比之下,图普科技给出的解决方案则更为简单:上传图片(视频直接截图),我给你分析,然后把结果交给你。

并且筛选的维度非常丰富:色情识别、暴恐识别、是否旋转、颜值、人物类别、广告识别、是否戴眼镜、头发长度、车身颜色、车标品牌、服装风格、服装美观度等等。如果你还有别的需求,图普也可以为你深度定制筛选规则。

使用流程也非常简单,将图片发送到图普的云处理端,然后就能够接收到来自云端的处理结果,同时反馈的还有机器对结果的确定程度(百分比)比如“图普有多确定这张图片是色情图片、图片里的人颜值有多高”。

这些复杂的维度即便是人也要花上个几秒钟来确定,而图普所能达到的成绩是 99.5% 的图片都能够在 0.2 秒内获得鉴别的数据反馈。

计算机究竟是如何迈过看懂图片这道门槛的?图普究竟用了什么黑科技?

一天 3 亿张,如何根据数据看“懂”图片?

同样的一张魔方图片图片,人眼看到的是一个魔方,而计算机看到只是每个代表每个像素点的数据。 虽说人对于图像的识别能力也是日积月累形成的,但如何教会计算机看“懂”图片一直是个难点。

“懂”这个字非常关键,日常我们会遇到的验证码就是个很好的例子。对于最简单的文字验证码,计算机能够通过分析图片中的像素点的颜色数值,然后形成一定的笔画结果,最终转化为文字。

所以人们就开始对验证码进行不断的升级,从更换、抽象字体到给验证码加上其他干扰元素等等,12306 的图片勾选就属于验证码中比较强力的一种。

8 张小小的图片,里面展现了不同的物体,然后根据提示勾选其中一个或几个才能通过验证。刚推出的时候瞬间所有抢票软件都哑火了,后来他们想出一个办法:通过数据请求获得所有的图片验证码,然后仍然是通过人工进行归类,最终刷票需要验证的时候通过图片原始数据就知道应该勾选哪几个了。

这种方式并没有真正看“懂”图片,只是利用人工完成了必须的鉴别环节,如果这个验证码的数据库足够大并且一直保持更新,破解就将变得非常困难。

只分析图片原始数据这种方法在应对复杂颜色图片的时候非常无力,比如之前通过鉴定图片中肉色的比例(根据像素点信息来判断)来排除黄色图片的某软件。结果是各种黄牛的图片也变成了色情图片,还有将两根火腿肠看成大腿的结果。

人工在鉴别的准确度上肯定有优势,但人不同于机器,总是会疲劳的,而且错误几乎不可避免,还需要付出大量的成本和时间进行管理。

既然给不出规则,就让计算机自己整理出规则

既然没有办法直接将人脑识别图像的流程代码化,那么只好从头跟人类学习了:通过识别大量的图片来形成电脑的自我认知。在上周的分享中 CEO 李明强是这样概括的:

最核心的原理与生物训练的比较类似——应激反应,一种是奖励一种是惩罚。做对了就强化他然后奖励,让他不断强化重复自己对的行为;做错的就去惩罚它,然后削弱他。

将上面一段换成技术名词就是:有监督的深度学习技术。

当然首先需要给计算机装备一个能够不断学习、自我成长的平台:多重神经网络。这个技术详细解释起来相当复杂,概括起来就是计算机会将原来单个、零散的分辨率数据结合起来,从不同的维度进行分析,比如颜色、相似度、局部特征等,同时与之前积累的数据进行对比,最终捕获其中的规律,将图像中的信息提取出来。

这是一个不断成长的过程,与我们婴儿时期父母亲自教我们辨认图像如出一辙。当然计算机的效率要高的多,同时还能够获得很多已经预先经过筛选的数据,让“学习”过程具备了先天优势。

所以在图普科技提出的解决方案中存在这样一个流程:如果计算机对于自己的判断自信度达不到 99.5%,图像数据就会返回给用户本身,由人工进行二次判断,不仅最大程度地保证了效果,同时还能从人给出的判断结果对规则进行修正。李明强还给出了自己的看法:

人工复审这个方式是我们的首创。因为人工智能存在一个陷阱:你可以用人工智能很快的完成事情的 50%——比如很多 Demo 都能够获得很好的效果,但实用的时候又很不靠谱。

所以我们需要告诉用户我们负责的 50% 确定能做好,我们不确定的 50%,你自己人工看一下。这样问题就可以完美解决,当然未来完全不用人工也是我们的努力方向,这个准确率会像曲线一样无限逼近,只要能够越来越节省人力,我觉得我们的目的就达到了。

图像的兴起以及新数据的发掘

在问及视频内容的兴起,以及对图普未来发展的影响时,李明强回答到:

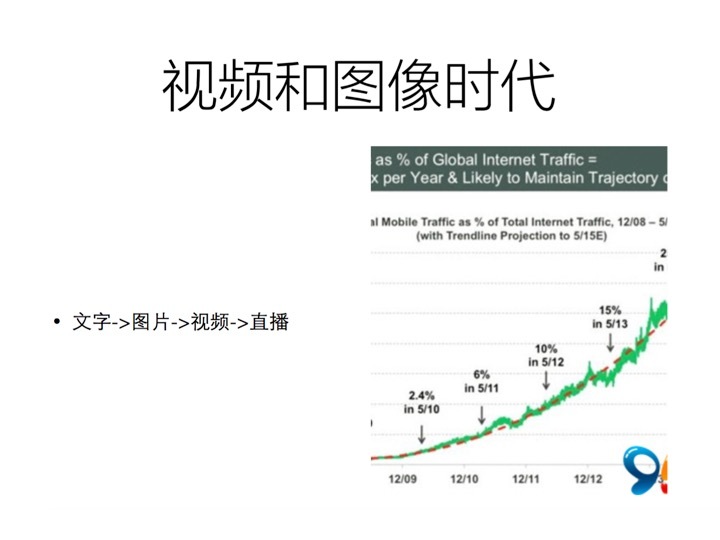

人工智能只是手段、工具,视频的爆发是必然的。

内容肯定是从简单到复杂、从静态到动态、从不可互动到互动性、从分时到实时这样一个趋势去发展的,所以移动视频这个爆发不是一个暂时的现象。

以后互联网里的内容很可能大部分都会以视频语音这种人类最本质的沟通方法进行传播,像文字这种类型的数据反而需要学习和理解。这就使得图像识别成为新的信息链接关键点了。

传统互联网中的信息主要存在于文字当中,他们的链接方式主要是超链接,通过无数个超链接,这些内容形成了一个庞大的库。但是落在图像身上之后,超链接的锚点就丢失了,因为你没有办法直接知道两个内容是否关联、哪些内容是关联的。用李明强自己的话来说就是:“图像识别技术在现在这个图像和视频时代,将会成为一项基础服务。”

所有内容都需要各种各样图像识别的接口,从各种维度去分析图像和视频,这样子才能够构建以图像和视频内容为主体的互联网 2.0 时代。

李明强还拿了他们一类非常典型的客户——视频网站/直播网站来举例:利用图普的技术对用户的上传的内容进行分析,然后将获得的反馈与用户连接起来。甚至于能够成为精准广告投放的根据。而图普科技的价值就在于:

在即将到来的图片和视频内容时代,为企业提供各种连接能力和增值服务,构建图片视频时代的新互联网业务模式。

人工智能创业火热,请保持清醒

当人类输掉世纪围棋人机大战之后,中国涌现出了好几个人工智能项目(包括同样着眼于围棋的人工智能项目“异构神机”),韩国还专门从政府中拨款扶持人工智能的产业发展。

对于为何人工智能最近呈现出一种全面爆发的态势,李明强这样回答道:

人工智能有三个关键,一个是数据、一个是计算能力、还有一个是算法,这 3 方面正好最近都成熟了。因为所有要素都到齐了,所以呈现出了一个大爆发的现象。

我们的最终目的是让机器睁开眼睛,去理解真实世界。

不过对于火热的“新风口”——人工智能创业,李明强还是表示出了一种谨慎。他认为类似图普的人工智能平台已经比较成熟了,但仍然存在很多机会。

如果想利用人工智能这个角度切入创业,还是需要先从人或者行业的角度去出发。究竟有哪些东西可以通过人工智能的方式去优化,提高效率,降低成本。这样才是符合商业路径的。

在每天与昨日都有大变化的互联网世界,新产品、新团队以及新模式层出不穷。他们中的一些虽然发展时间不长,却带来了让人眼前一亮的新想法、新突破。本期 MindStore 热点专访采访对象是:图普科技。

本文是 MindStore 采访第 77 篇。