矩阵?终结者?微软 CEO 用 6 条规则将人工智能无害化

近期,微软 CEO 纳德拉在 Slate 上发表了自己对于人工智能安全设计的思考。他认为人工智能和人类在未来可以和谐相处:

我们希望创造可以增强人类能力和体验的人工智能。最终,人类和机器不应该是敌对的关系。人类的创造性、同情心和洞察力可以和人工智能的计算能力有机地结合在一起,推动社会进步。

纳德拉是一个乐观派,但他的乐观是建立在理性思考上的。

(图片来自:The New Yorker)

他认为,要实现这个目标,对有害的副作用的防范至关重要。对此,他提出了 6 条规则,以指导人工智能的安全设计。

- 人工智能必须成为人道的辅助。

纳德拉认为,随着人工智能越来越自主化,人们的生活应该更加自由。机器应该代替人类去做一些如采矿一类的危险工作,让我们的生活更安全。

- 人工智能技术必须透明、公开。

当机器可以近乎无限制地学习用户的行为,人类更加应该了解人工智能技术的工作方式。反之,信息不对等会带来巨大的危险。

- 人工智能在促进生产效率的同时,不能有害于人类的尊严。

纳德拉在此强调,科技产业不能刻意引导未来价值观与道德的发展趋势。当硅谷的大公司都在宣扬“科技改变世界”的信条,人工智能的设计应该倾听不同人群的声音。

- 人工智能必须保障用户隐私。

人工智能的设定应该尊重个人和群体的隐私保护意愿。比如,Facebook 和 Google 都以挖掘个人数据营利,而它们复杂的隐私设定,让用户的大部分隐私都暴露给人工智能。这种模式是纳德拉所反对的。

- 人工智能必须有可更改的算法。

这样可以通过修改人工智能的设定来规避风险,将意料之外的危害降到最低。

- 人工智能应反对歧视。

纳德拉反对人工智能对于边缘化人群的歧视,这多少也暗合了硅谷自由派的价值观。

在纳德拉之前,有不少人表达过类似的忧虑。

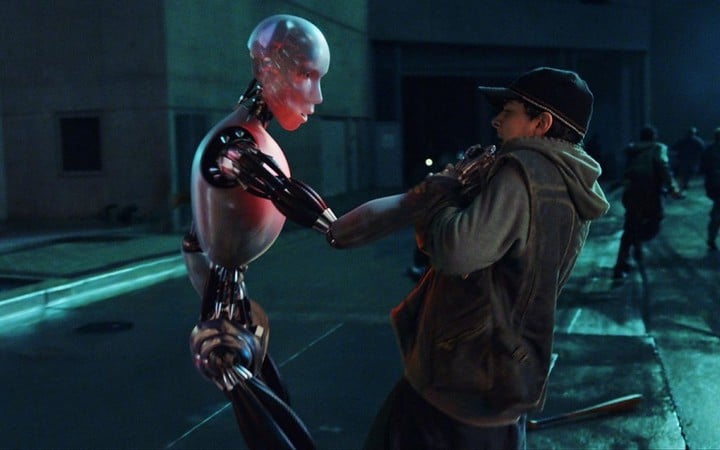

(图片来自:Huffington Post)

1942 年,科幻巨擘阿西莫夫出版了短篇小说 Runaround,并在其中提出了著名的机器人三定律。这套规则被广泛引用,用来探讨在科技进步中如何防止机器人对人类的伤害。

- 机器人不能伤害人或因不作为使人类受到伤害。

- 除非违背第一定律,机器人必须服从人类的命令。

- 除非违背第一季第二定律,机器人必须保护自己。

阿西莫夫的人工智能规则看似严谨,但也有很多人认为其仅有文学上的,而非现实上的价值。比如,这套规则并不能防止人工智能修改自身的设定以摆脱人类的控制。

这种担忧看似是杞人忧天,而事实上,近年来如比尔·盖茨和霍金等都发表过对人工智能潜在危险的担心。

学术界对此问题的探讨起步更早,法国哲学家让-弗朗索瓦·利奥塔早在 1988 年出版的著作《非人道》中就提出过,科技的演进有其内在的逻辑,独立于人类的意愿之外。科技永远只遵循效率优先的原则,而非以人为本。他预言,总有一天人类会失去对科技发展的控制,并被科技奴役。

(图片来自:Movie Pilot)

The Verge 评论道,跟阿西莫夫的三定律相比,微软 CEO 的 6 条原则显然缺少了趣味性,但是其对整个产业的发展来说却是更有指导意义的。

纳德拉的担忧更侧重人工智能潜在的社会影响,而不是反对机器人走进千家万户。人工智能若想增进人类福祉,扫除潜在危险,或许需要有更多如纳德拉这样的领导者出面,为道德演进指明方向。

题图来自:Masters of Media