搜狗发布“知音”语音引擎,让语音助手会纠错、会沟通

心急如焚的你要赶往机场,语音助手却偏和你唱反调。你降低语速,反复说了几遍,它才明白你要去哪,最终却导向了错误的航站楼。语音助手 “不智能”、没帮助的痛点,即是搜狗“知音”想要解决的。

今日,搜狗发布了新的智能语音引擎“知音”,宣称要把搜狗语音助手打造的更加智能,达到“能理解会思考”的程度。对此,CTO 杨洪涛和语音负责人王砚峰登台进行详细介绍。

“知音”想解决的第一个痛点是语速过快导致的吞音问题。当你讲话过快时,很多语音助手会因为音节的模糊而发生识别错误。而搜狗称,“知音”的识别速度与前代相比可以提升 3 倍,而错误率则可以下降约 30%。

在发布会上,搜狗全程使用了它们的实时转写技术。二位主讲全程都没有故意放慢语速,而“知音”实时投放在大屏幕上的字幕,则保持着还算不错的准确度。当然,用词错误的情况还是无法避免的。

此外,“知音”想解决的第二个痛点是纠错问题。我们通常用语音输入文字,由于识别不清,免不了要换回键盘继续再修改错别字。搜狗为了让语音识别彻底摆脱键盘,允许你通过语音进行修改。

比如,根据王砚峰的介绍,你可以直接告诉语音助手:把弓长“张”换成立早“章”,或者,把山峰的“峰”换成烽火的“烽”,语音助手就会自动为你修改。

搜狗称,能实现这一点,与现有业务的数据储备是分不开的。搜狗输入法的词库、拆字库、用户的语料库,以及百科知识图谱,都为“知音”的识别能力提供了数据支撑。

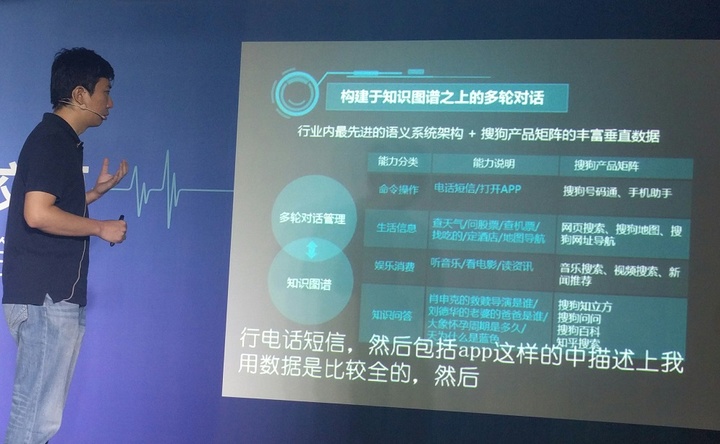

而“知音”想要解决的第三个痛点则是对用户真实意图的识别。为此,他们为“知音”加入了一个多轮对话的功能。

根据搜狗在现场的演示视频,当你告诉“知音”你的目的地是首都国际机场时,知音不会马上为你规划路线,而是会进行对话。它会询问你要去的航站楼、航班号,问你直接去航站楼,还是停车场,一切确定之后才会生成导航路径。

这种场景会话能力与 Google 今年在 I/O 上介绍的以对话为基础的新语音功能类似,会结合你之前问过的问题提供信息,而不是让这个过程变成机械的一问一答。

王砚峰称,机器的语义理解在 5 年内将不会有太大突破,当前的技术水平不足以支撑问题难度,因此机器想具有人的理解能力还有很大距离。

深谙这个道理的搜狗,选择搁置技术瓶颈,利用现有服务的数据,结合用户各种使用场景,希望让语音助手达到真正对用户有帮助,而不是制造更多麻烦。

杨洪涛认为,只有真正考虑用户的使用场景,才能帮助语音平台积累数据,最终达到数据反哺机器学习技术的效果。

目前,iOS 版搜狗语音助手已经上线了语音纠错功能, Android 版稍后会迎来更新。