腾讯混元大模型正在加快开源步伐。

11月5日,腾讯混元宣布最新的MoE模型“混元Large“以及混元3D生成大模型“ Hunyuan3D-1.0”正式开源,支持企业及开发者精调、部署等不同场景的使用需求,可在HuggingFace、Github等技术社区直接下载,免费可商用。

本次开源是腾讯混元继文生图模型后持续开放的一大举措。其中,腾讯混元Large是目前开源领域参数规模最大、效果最好的MoE模型,而腾讯混元3D生成大模型则是业界首个同时支持文字、图像生成3D的开源大模型。两个模型均属腾讯自研,在架构、算法、数据等方面有独特创新,填补了行业空白。目前,两个模型均已经在腾讯业务场景中落地应用,经过实践的检验,是面向实用场景的应用级大模型。

当天,腾讯云TI平台和高性能应用服务HAI也开放接入这两个模型,为模型的精调、API调用及私有化部署提供一站式服务。

坚持MoE架构,模型持续升级开放

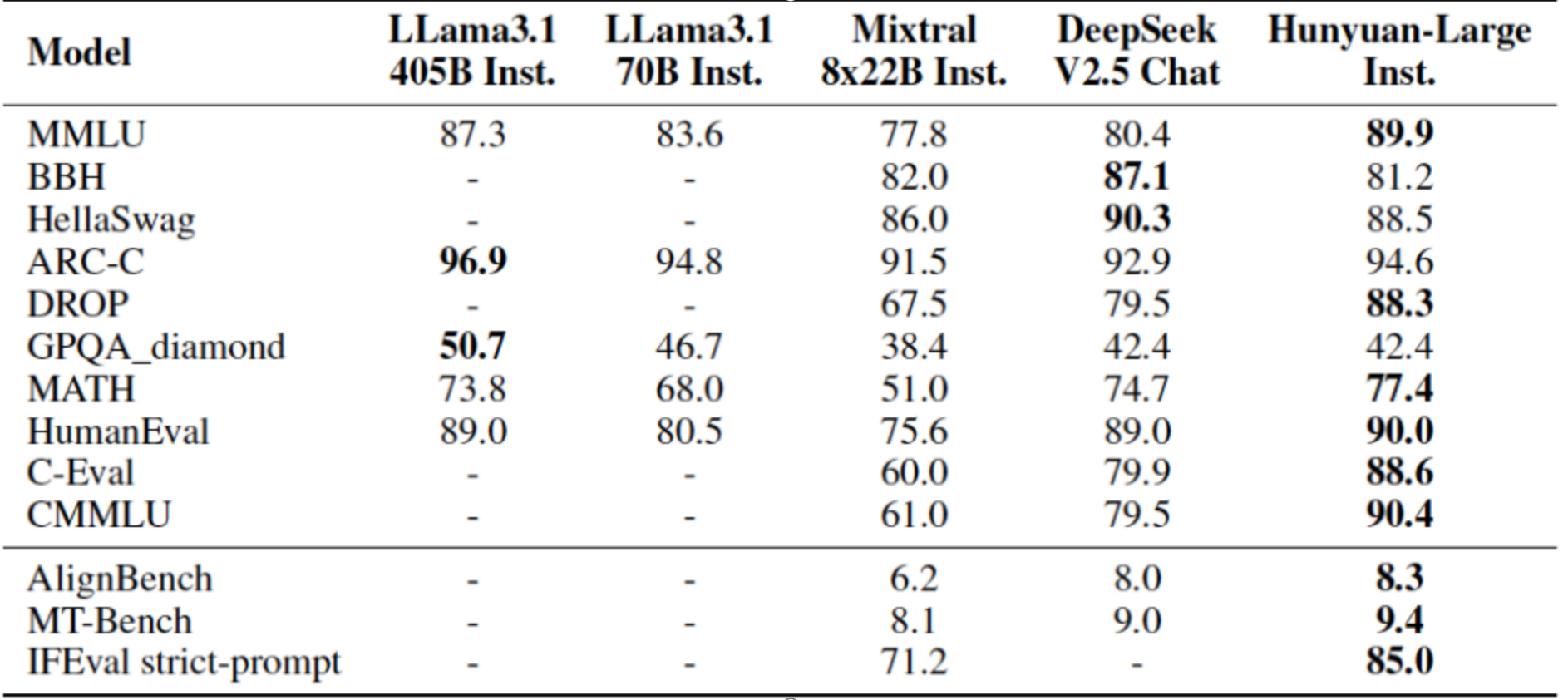

腾讯混元Large模型总参数量 389B,激活参数量 52B ,上下文长度高达256K,公开测评结果显示,腾讯混元Large 在CMMLU、MMLU、CEval、MATH等多学科综合评测集以及中英文NLP任务、代码和数学等9大维度全面领先,超过Llama3.1、Mixtral等一流的开源大模型。

▲腾讯混元Large 在各类测试集上得分领先现有主流开源模型.

MoE(Mixture of Experts),即混合专家模型,是目前国内外主流的大模型结构。2024年年初,腾讯混元就宣布在国内率先采用MoE架构模型,总体性能比上一代Dense模型提升50%。此后,腾讯混元推出基于 MoE 架构的多模态理解大模型以及基础模型”混元turbo”,在性能、效果、速度等多个领域表现优越,第三方测评居国内大模型第一。

在模型结构和训练策略方面,腾讯混元Large全面探索了MoE ScalingLaw,进行了MoE共享专家路由、回收路由等策略上的创新,并引入了专家特化的学习率适配训练策略,有效提升不同专家利用率和稳定性,带来模型效果的提升。

腾讯混元Large在Post-Train方面做了大量创新优化。面对SFT通用领域繁多,数学、代码高质量指令数据获取困难,业界广泛采用的离线DPO,强化策略效果上限不高,泛化性弱等挑战,腾讯混元Large模型分门别类提升数学、逻辑推理、代码等能力,另外在一阶段离线DPO的基础上引入了二阶段在线强化策略。

数据方面,腾讯混元Large构建了覆盖数十个类目,高质量、高多样性、大量级的中英文合成数据,显著提升模型效果,其中数学和代码效果提升超过10%。 针对长文领域测评数据集缺乏,方法不够客观等问题,腾讯混元Large还基于公开数据,构建了一套完整覆盖长文阅读理解、多文档摘要总结、长文逻辑推理等领域任务的数据集企鹅卷轴(PenguinScrolls),并将对外开放,助力大模型长文方向的技术研究。

腾讯混元Large模型专项提升的长文能力已经应用到腾讯AI助手腾讯元宝上,最大支持256K上下文,相当于一本《三国演义》的长度,可以一次性处理上传最多10个文档,并能够一次性解析多个微信公众号链接、网址,让腾讯元宝具备独有的深度解析能力。

工程平台方面,腾讯混元Large模型由腾讯自研,其训练和推理均基于腾讯Angel机器学习平台。其中,针对 MoE 模型通信效率问题,Angel训练加速框架AngelPTM实现了多项技术优化,性能是主流开源框架DeepSpeed的2.6倍;针对模型推理加速,腾讯Angel机器学习平台和腾讯云智能联合研发 AngelHCF-vLLM框架,在最大限度保障精度的条件下,可节省50%以上显存,相比于业界主流的框架BF16吞吐提升1倍以上。

腾讯混元Large 模型已同步上架腾讯云 TI平台。TI 平台具备实战型大模型精调工具链,提供灵活的大模型训练数据标注能力和开源的数据构建Pipeline,内置 Angel训练和推理加速能力,支持一键启动混元Large精调,帮助用户训练出真正满足业务需求的专属大模型,提升研发效率。

同时,腾讯混元大模型 PaaS平台开放支持包含混元 Large 模型在内的十余种混元API 服务调用,可满足文生文、图生文、文生图等不同模态以及角色扮演、FunctionCall、代码等不同专项的模型需求。

业界首个同时支持文字、图像生成3D的开源大模型

腾讯混元3D生成大模型首批开源模型包含轻量版和标准版,轻量版仅需10s即可生成高质量3D资产,目前已在技术社区公开发布,包含模型权重、推理代码、模型算法等完整模型,可供开发者、研究者等各类用户免费使用。

腾讯混元Hunyuan3D-1.0 模型也已上架到腾讯云HAI,通过HAI上更高性价比的GPU算力、模型一键部署能力和可视化图形界面WebUI,有效降低模型开放和部署门槛。

此次腾讯混元开源的3D生成大模型 Hunyuan3D-1.0 ,解决了现有的3D生成模型在生成速度和泛化能力上存在不足的问题,可以帮助 3D 创作者和艺术家自动化生产 3D 资产。该模型具有强大泛化能力和可控性,可重建各类尺度物体,大到建筑,小到工具花草。经过定性、定量多个维度的评估,腾讯混元3D生成大模型的生成质量已达到开源模型的先进水平。

在两个公开的3D数据集 GSO 与 OmniObject3D 上,腾讯混元Hunyuan3D-1.0 效果优于主流开源模型,整体能力属于国际领先水平。从定性角度评估,Hunyuan3D-1.0 与行业领先的开源模型的 3D 生成效果表现对比也显示出较高水平,包括几何细节、纹理细节、纹理-几何一致性、3D合理性、指令遵循等评价维度。

应用上,3D生成相关技术已经开始应用于UGC 3D创作、商品素材合成、游戏3D资产生成等腾讯业务中。其中,腾讯地图基于腾讯混元3D大模型,发布了自定义3D导航车标功能,支持用户创作个性化的 3D 导航车标,相比传统的3D车标重建方案,速度提升了91%。此前,腾讯元宝 APP 也上线了”3D 角色梦工厂“玩法,支持个性化的 UGC 3D 人物生成。

随着自研大模型技术强大的和应用实践经验的丰富,开源已经成为腾讯混元大模型的一个战略选择,未来,腾讯混元也将继续带来更多模态、更多尺寸的开源模型,将更多经过腾讯业务场景打磨和检验的模型开源,促进大模型技术进步和行业生态繁荣。

附:腾讯混元Large访问地址

官网地址:https://llm.hunyuan.tencent.com/

Github地址:

https://github.com/Tencent/Tencent-Hunyuan-Large

Hugging Face 地址:

https://huggingface.co/tencent/Tencent-Hunyuan-Large

附:腾讯3D模型访问地址

官网地址:https://3d.hunyuan.tencent.com/

Github 地址:https://github.com/Tencent/Hunyuan3D-1

Hugging Face 模型地址:https://huggingface.co/tencent/Hunyuan3D-1